始于 2021年12月17日,出发点是为了让更多国人可以直观的学习并使用 Proxmox VE 。本译文极小部分的内容并未完全按照英文原版的内容进行直接翻译,可能存在个人主观上的理解和认知,如有发现不合适甚至错误的地方,请以英文原版为主。

Proxmox VE 管理员指南

<support@proxmox.com>

版本 7.1, 2021月11月15日 欧洲中部时间 16:07:34

始于 2021年12月17日,出发点是为了让更多国人可以直观的学习并使用 Proxmox VE 。本译文极小部分的内容并未完全按照英文原版的内容进行直接翻译,可能存在个人主观上的理解和认知,如有发现不合适甚至错误的地方,请以英文原版为主。

Proxmox VE 是一个运行虚拟机和容器的平台,基于 Debian Linux,完全开源。为了获得最大的灵活性,我们实现了两种虚拟化技术-基于内核的虚拟机(KVM)和基于容器的虚拟化(LXC)。

一个主要的设计目标是使管理尽可能简单。您可以在单个节点上使用 Proxmox VE,或将多个节点组成集群。所有管理任务都可以通过我们基于 Web 的管理界面来完成,即使是新手用户也可以在几分钟内安装 Proxmox VE 。

虽然很多人从单个节点开始,但 Proxmox VE 可以扩展为大型的集群化节点。集群堆栈(Stack)完全集成,并在默认安装中附带。

集成的基于 Web 的管理界面为您提供了所有 KVM 来宾和 Linux 容器甚至整个集群的清晰概览。您可以轻松的从 GUI 界面管理您的虚拟机(VM)(以下简称 VM)和容器(CT)(以下简称 CT)、存储或集群。无需安装单独、复杂且昂贵的管理服务器。

Proxmox VE 使用独特的 Proxmox 集群文件系统(pmxcfs),一个数据库驱动的文件系统用于存储配置文件。这可以让您存储数千个虚拟机的配置。通过使用 corosync ,这些文件可以在所有集群节点上实时复制。文件系统将所有数据存储在磁盘的持久数据库中,尽管如此,还是为驻留在内存中的数据副本提供了最大 30MB 的存储大小 - 对于数千个 VM 来说已经足够了。

Proxmox VE 是唯一使用这种独特的集群文件系统的虚拟化平台。

Proxmox VE 易于使用。通过包含的基于 Web 的管理界面来完成管理任务 - 无需安装单独的管理工具或任何具有大型数据库的额外管理节点。多主工具允许您从集群的任何节点管理您的整个集群。基于 Web 的集中式管理 - 基于 JavaScript 框架(ExtJS)- 使您能够从每个节点的概要、任务历史和系统日志(Syslog)中控制所有功能。这包括正在运行的备份或恢复作业、实时迁移或 HA 触发的活动。

对于习惯使用 Unix shell 或 Windows Powershell 的高级用户,Proxmox VE 为您提供了一个命令行界面来管理虚拟环境的所有组件。该命令行界面具有 Tab 智能补全和 UNIX 手册页形式的完整文档。

Proxmox VE 使用 RESTful API 。我们选择 JSON 为主数据格式,并且整个 API 使用 JSON Schema 正式定义。这样可以快速轻松地集成第三方管理工具,例如自定义托管环境。

您可以通过使用基于角色的用户和权限管理,来定义所有对象( VM 、存储、节点等)的精细访问。这允许您定义权限并帮助您控制对象的访问。这个概念也称为访问控制列表(即 ACL):每个权限在特定路径上指定一个主题(用户或组)和一个角色(权限集合)。

Proxmox VE 支持多种认证源,诸如 Microsoft 活动目录(AD)、LDAP、Linux PAM 标准认证或 Proxmox VE 内置的认证服务器。

Proxmox VE 的存储模型非常灵活。虚拟机映像可以存储在一个或多个本地存储中,或存储在诸如 NFS 和在 SAN 上的共享存储中。没有任何限制,您可以配置更多您想要定义的存储。可以使用在 Debian Linux 中可用的所有存储技术。

将虚拟机 VM 存储在共享存储上的主要优势是能够在不停机的实时迁移正在运行的虚拟机,而且集群中的所有节点都可以直接访问虚拟机 VM 的磁盘映像。

我们当前支持以下网络存储类型:

LVM 卷组(通过 iSCSI 目标进行网络备份)

iSCSI 目标

NFS 共享

CIFS 共享(也称作 SMB)

Ceph RBD

直接使用 iSCSI LUN

GlusterFS(一种集群式文件系统)

支持的本地存储类型:

LVM 卷组(通过类似的块设备、FC 设备、DRBD 等进行本地备份)

目录 (存储在现有文件系统上)

ZFS

集成的备份工具(vzdump)为运行中的容器和 KVM 来宾创建一致的快照。从根本上说,它创建了一个包含有 VM / CT 配置文件的 VM 或 CT 的数据存档。

KVM 实时备份适用于所有存储类型,包括 NFS、CIFS、iSCSI LUN、Ceph RBD 上的 VM 映像。新的备份格式经过优化,可以快速有效地存储 VM 的备份(稀疏文件、无序数据、最小化 I/O)。

一个多节点的 Proxmox VE HA 集群支持定义高可用性的虚拟服务器。Proxmox VE 的 HA 集群基于成熟的 Linux HA 技术,提供稳定可靠的 HA 服务。

Proxmox VE 使用桥接网络模型。如果每个来宾的虚拟网络电缆都插入同一交换机,则所有 VM 都可以共享一个网桥。为了将 VM 连接到外部世界,网桥连接到物理网卡并分配了一个 TCP/IP 配置。

为了进一步提高灵活性,可以使用 VLAN(IEEE 802.1q)和网络绑定(bond)/ 聚合。通过这种方式,可以为 Proxmox VE 主机构建复杂、灵活的虚拟网络,充分利用 Linux 网络堆栈的强大能力。

集成的防火墙允许您筛选任何 VM 或容器接口上的网络数据包。常见的一组防火墙规则可以组合为“安全群组”。

Proxmox VE 是一个虚拟化平台,它紧密集成了计算、存储和网络资源,管理高可用性集群,备份/恢复以及灾难恢复。所有组件都是软件定义,并且彼此兼容。

因此,可以通过集中式的 Web 管理界面,像单个系统一样管理它们。这些功能使得 Proxmox VE 成为部署和管理开源 超融合架构 的理想选择。

超融合架构(HCI)对于高架构需求满足低管理预算的部署、远程和分支机构办公环境等分布式设置、或虚拟私有云和公共云特别有用。

超融合架构(HCI)具有以下优势:

可扩展性:计算、网络和存储设备的无缝扩展(即快速、独立地扩展服务器和存储)。

低成本:Proxmox VE 是开源的,并集成了您需要的所有组件,例如计算、存储、网络、备份和管理中心。它可以取代昂贵的计算/存储基础设施。

数据保护和效率:集成了备份和灾难恢复等服务。

简单:易于配置和集中管理。

开源:没有供应商锁定。

Proxmox VE 为部署超融合存储架构提供了紧密集成的支持。例如,您可以仅使用 Web 界面来部署和管理以下两种存储技术:

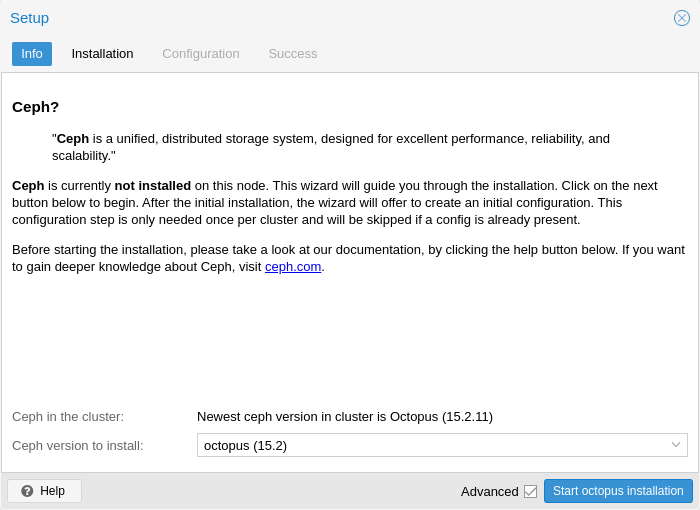

Ceph:一个兼具自我修复和自我管理的共享、可靠和高度可扩展的存储系统。查看 如何在 Proxmox VE 节点上管理 Ceph 服务 。

ZFS:结合了文件系统和逻辑卷(LVM)管理器,具有广泛的数据损坏保护、各种 RAID 模式、快速且实惠的快照 - 以及其他大量的功能。了解 如何在 Proxmox VE 节点上利用 ZFS 的强大能力 。

除此之外,Proxmox VE 支持集成各种附加存储技术。您可以在 存储管理章节 中找到有关它们的信息。

Proxmox VE 使用 Linux 内核并基于 Debian GNU/Linux 发行版。Proxmox VE 的源代码根据 GNU Affero 通用公共许可证,版本 3 发布的。这意味着您可以随时检查源代码或为项目作出贡献。

在 Proxmox ,我们致力于尽可能的使用开源软件。使用开源软件确保对所有功能的完全访问 - 以及高安全性和可靠性。我们认为每个人都应该有权访问软件的源代码来运行它,在它的基础上构建,或者将更改提交回项目。我们鼓励每个人都做出贡献,同时 Proxmox 确保产品始终符合专业质量标准。

开源软件还有助于保持低成本并使您的核心基础设施独立于单一供应商。

开源软件

无供应商锁定

Linux 内核

快速安装且易于使用

基于 Web 的管理界面

REST API

庞大的活跃社区

低管理成本且易于部署

Proxmox VE Wiki 是信息的主要来源,它结合了参考文档和用户贡献的内容。

我们始终鼓励我们的用户使用 Proxmox VE 社区论坛 讨论和分享他们的知识。该论坛由 Proxmox 支持团队主持。庞大的用户群遍布全球,因此不用多说,这样的大型论坛是获取信息的好地方。

这是通过电子邮件与 Proxmox VE 社区进行交流的一种快速方式。

用户邮件列表:PVE User List

Proxmox VE 是完全开源的,欢迎贡献!开发人员的主要沟通渠道是:

开发者邮件列表:PVE development discussion

Proxmox Server Solutions GmbH 以 Proxmox VE 订阅服务计划 的形式提供企业支持。所有订阅用户都可以访问 Proxmox VE 的 Enterprise Repository(企业存储库),并且拥有 Basic、Standard 或 Premium 订阅的还可以访问 Proxmox 客户门户(Portal)。该客户门户可以在 Proxmox VE 开发人员保证的响应时间内提供帮助和支持。

如需批量折扣或更多常规信息,请联系 office@proxmox.com 。

Proxmox 在 https://bugzilla.proxmox.com 上运行一个公共的 bug 追踪器。如果出现问题,请在此处提交报告。此问题可以是一个 bug ,也可以是一个新功能或增强功能的请求。Bug 追踪器有助于该问题的跟进,并在问题解决后发送通知。

本项目于 2007 年开始,随后在 2008 年发布了第一个稳定版本。当时,我们为容器使用 OpenVZ,而为虚拟机使用 KVM 。集群功能有限,并且用户界面也简单(由服务器生成的网页)。

但是,我们使用 Corosync 集群堆栈快速开发了新功能,而且新的 Proxmox 集群文件系统(pmxcfs)的引入也是向前迈出了一大步,因为它完全向用户隐藏了集群的复杂性。管理 16 个节点的集群就像管理单个节点一样简单。

我们还引入了一个新的 REST API ,它具有用 JSON 模式编写的完整声明性规范。这使其他人能够将 Proxmox VE 集成到他们的基础设施中,并使得它易于提供附加服务。

此外,新的 REST API 使用一个现代的、运用 JavasScript 的 HTML5 应用程序代替原始的用户界面。我们也使用 noVNC 替换了旧的基于 Java 的 VNC 控制台代码。因此,您仅需要一个 Web 浏览器来管理 VM 。

另一项大任务是对各种存储类型的支持。值得注意的是,Proxmox VE 是在 2014 年默认第一个在 Linux 上发布 ZFS 的发行版。另一个里程碑是能够在管理程序的节点上运行并管理 Ceph 存储,这样的设备极具成本效益。

当我们开始时,我们是第一批为 KVM 提供商业支持的公司之一。KVM 项目自身不断发展,现在是一个广泛使用的管理程序。每个版本都会提供新功能。我们开发了 KVM 实时备份功能,使其在任何类型的存储上创建快照备份成为可能。

Proxmox VE 4.0 版本最显著的变化是从 OpenVZ 迁移到 LXC 。容器现在已深度集成,它们可以使用与虚拟机相同的存储和网络功能。

始终欢迎对 Proxmox VE 文档的贡献和改进,这里有几种贡献方式。

如果您在本文档中发现错误或其他有待改进的地方,请在 Proxmox bug 追踪器 中提交 bug,以提出更改建议。

如果您想提出新内容,请选择以下选项之一:

Wiki:对于特定的设置、操作指南或教程,wiki 是正确的选择。

参考文档:对于所有用户都有帮助的常规内容,请提出您对参考文档的贡献。这包括如何安装、配置、使用和故障排除等相关的 Proxmox VE 功能的所有信息。参考文档以 asciidoc 格式 编写。要编辑文档,您需要在 git://git.proxmox.com/git/pve-docs.git 克隆 git 仓库;然后按照 README.adoc 文档进行操作。

|

|

如果您对使用 Proxmox VE 代码库感兴趣,开发者文档 wiki 文章将告诉您从哪里开始。 |

Proxmox VE 用户界面默认为英文。但是,感谢社区的贡献,也有翻译成其他语言。我们欢迎在添加新语言、翻译最新功能以及改进不完整或不一致的翻译方面提供任何支持。

您可以通过执行以下操作来创建新的翻译(将 <LANG> 替换为语言 ID):

# git clone git://git.proxmox.com/git/proxmox-i18n.git # cd proxmox-i18n # make init-<LANG>.po

或者您可以使用您选择的编辑器编辑现有翻译:

# poedit <LANG>.po

为了在 Proxmox VE 中使用翻译,您必须首先将 .po 文件转换为 .js 文件。您可以通过调用位于同一个存储库中的以下脚本来执行操作:

# ./po2js.pl -t pve xx.po >pve-lang-xx.js

然后将生成的文件 pve-lang-xx.js 复制到 Proxmox 服务器的目录 /usr/share/pve-i18n 中,以便对其进行测试。

或者,您可以通过从存储库的根目录运行以下命令生成一个 deb 软件包:

# make deb

|

|

要使这些方法中的任何一种起作用,您需要在系统上安装以下 perl 软件。对于 Debian/Ubuntu : |

# apt-get install perl liblocale-po-perl libjson-perl

您可以将完成的翻译(.po 文件)连同签署的贡献许可协议一起发送到 Proxmox 团队的地址 office(at)proxmox.com 。或者,如果您有一些开发经验,您可以将其作为补丁发送到 Proxmox VE 开发邮件列表。请参阅 开发者文档 。

Proxmox VE 基于 Debian,所以 Proxmox 提供的安装映像(ISO文件)包含了完整的 Debian 系统以及所有必要的 Proxmox VE 软件包。

|

|

查看 在 FAQ 中的支持表 了解 Proxmox VE 版本和 Debian 版本之间的关系。 |

安装程序将指导您完成安装过程,允许您对逻辑磁盘进行分区、应用基本的系统配置(例如:时区、语言、网络等)、并安装所需要的软件包。此过程只需要花费几分钟时间,推荐新手或现有用户通过提供的 ISO 进行安装操作。

或者,可以安装 Proxmox VE 在现有 Debian 系统上,此选项仅建议详细了解 Proxmox VE 的高级用户使用。

我们推荐在生产环境使用高质量服务器硬件运行 Proxmox VE 。为了进一步减少故障主机的影响,您可以在具有高可用性(HA)的集群中运行 Proxmox VE 的虚拟机和容器。

Proxmox VE 可以使用本地存储(DAS),SAN,NAS 和分布式存储(如 Ceph RBD)。有关详细信息,请参阅 存储章节。

这些最低需求仅用于评估目的,不应用于生产环境。

CPU:64位处理器 (Intel EMT64 或 AMD64)

主板:支持 Intel VT/AMD-V CPU和支持 KVM 完全虚拟化的主板

内存:1 GB 内存,需为“来宾”增加额外的内存

硬盘:至少 1 个硬盘

网卡:至少 1 个网卡

带有 Intel VT/AMD-V CPU 标志的 Intel EMT64 或 AMD64 的处理器

内存:操作系统和 Proxmox VE 服务最少需要 2 GB,外加为“来宾”指定的内存。对于 Ceph 和 ZFS,需要额外的内存 - 每 TB 的已用存储大约需要 1GB 内存(即 1TB 存储 ≈ 1GB 内存)。

快速冗余存储,SSD 可实现最佳效果。

系统存储:使用带电池保护的写缓存 (“BBU”)的硬件 RAID 或带 ZFS 的非 RAID(ZIL 可选 SSD)。

虚拟机存储:

对于本地存储,要么使用带电池备份写缓存(BBU)的硬件 RAID,要么使用 non-RAID 的 ZFS 和 Ceph 。ZFS 与 Ceph 均与硬件 RAID 控制器不兼容。

可用的共享和分布式存储。

冗余 (多个) 千兆网卡,附加的网卡取决于首选的存储技术和集群设置。

对于直通 PCI(e) ,CPU 需要支持 VT-d/AMD-d 标志。

通过运行附带的 pveperf 工具,可以获得安装了 Proxmox VE 系统的 CPU 和硬盘性能的概况。

|

|

这只是一个非常快速和通用的基准测试。建议进行更详细的测试,尤其是有关系统 I/O 性能的测试。 |

要访问基于 Web 的用户界面,推荐使用以下浏览器之一:

Firefox 火狐浏览器,当年发布的最新版本,或最新的 ESR 版本

Chrome 谷歌浏览器,当年发布的最新版本

Microsoft Edge 浏览器,微软当前支持的版本

Safari 浏览器,当年发布的最新版本

当从移动设备访问时,Proxmox VE 将显示一个轻量级的基于触摸的界面。

Proxmox VE 安装介质是一个混合 ISO 映像,它有两种工作方式:

准备刻录到 CD 或 DVD 的 ISO 映像文件。

准备复制到 USB 闪存驱动器的原始扇区(IMG) 映像文件。

推荐使用 USB 闪存驱动器安装 Proxmox VE(这是更快的选项)。

闪存驱动器需要至少 1 GB 的可用存储空间。

|

|

不要使用 UNetbootin,它不适用于 Proxmox VE 安装映像。 |

|

|

确保 USB 闪存驱动器未安装且不包含任何重要数据。 |

在类 Unix 操作系统上使用 dd 命令复制 ISO 映像到 USB 闪存驱动器。首先找到 USB 闪存驱动器的正确设备名称(见下文)。然后运行 dd 命令。

# dd bs=1M conv=fdatasync if=./proxmox-ve_*.iso of=/dev/XYZ

|

|

确保使用正确的设备名称替换 /dev/XYZ,并调整输入的文件名路径 (if 后面) 。 |

|

|

请非常小心,不要覆盖错误的磁盘! |

有两种方法可以找到 USB 闪存驱动器名称。第一种是通过 dmesg 命令,比较插入闪存驱动器之前与之后输出的最后几行内容。第二种方法通过比较 lsblk 命令的输出。打开一个终端并运行:

# lsblk

然后插入您的 USB 闪存驱动器并再次运行此命令:

# lsblk

将出现一个新设备,这就是您要用的。为了更安全起见,请检查报告的大小是否与您的USB闪存驱动器匹配。

打开终端 Terminal(在 Spotlight 中查询终端 Terminal)。

例如,使用 hdiutil 的 Convert 选项,将 .iso 文件转换为 .img 文件。

# hdiutil convert -format UDRW -o proxmox-ve_*.dmg proxmox-ve_*.iso

|

|

macOS 倾向于自动添加 .dmg 到输出文件名中。 |

要获取设备的当前列表,请运行以下命令:

# diskutil list

现在插入USB闪存驱动器并再次运行此命令,以确定已为其分配了哪个设备节点。(比如 /dev/diskX)

# diskutil list # diskutil unmountDisk /dev/diskX

|

|

将 X 替换为上一个命令中的磁盘号。 |

# sudo dd if=proxmox-ve_*.dmg of=/dev/rdiskX bs=1m

|

|

最后的命令中使用 rdiskX 代替 diskX 可以提高写入速度。 |

Etcher 开箱即用,从 https://etcher.io下载 Etcher,它将引导您完成选择 ISO 和 USB 驱动器的过程。

Rufus 是更轻量级的替代品,但是您需要使用 DD 模式 使其起到作用。从 https://rufus.ie/ 下载 Rufus,可以安装它或选择使用便捷版本。选择目标驱动器和 Proxmox VE ISO 文件。

|

|

单击 开始 以后,当有对话框询问是否下载不同版本的 GRUB 时,您必须单击 不 ,并在下一个对话框中选择 DD 模式。 |

此 ISO 安装映像包括以下内容:

完整的操作系统 (Debian Linux,64位)

Proxmox VE 安装程序,它使用 ext4,XFS,BTRFS(技术预览)或 ZFS 对本地磁盘进行分区,并安装操作系统。

Proxmox VE Linux 内核(支持 KVM 和 LXC)

用于管理虚拟机、容器、主机系统、集群和所有必要资源的完整工具集。

基于 Web 的管理界面

|

|

安装过程中将删除安装中所选驱动器的所有数据。安装程序不会为其它操作系统添加启动菜单项。 |

请插入准备好的安装介质(比如 USB 闪存驱动器 或 CD-ROM)并从它引导启动。

|

|

确保在您的服务器固件中启用了从安装介质(比如 USB)引导的设置。 |

启动标准安装程序。

|

|

可以仅用键盘来使用安装向导。通过按 ALT 键并结合相应按钮中带下划线的字符,实现单击按钮的效果。比如,ALT + N 相当于单击 Next 按钮。 |

以调试模式开始安装。在相应的安装步骤中将打开控制台,如果出现错误,这有助于调试情况。按 CTRL-D退出调试终端。此选项可用于引导至一个带有基本工具的即时系统,比如,您可以使用它 修复降级的 ZFS rpool 或修复现有 Proxmox VE 设置的 bootloader 。

使用此选项,您可以引导到一个存在的系统。它会搜索所有连接的硬盘,如果找到已安装的系统,它会使用 ISO 中的 Linux 内核引导到该磁盘。如果出现引导块(GRUB)或 BIOS 无法从该磁盘读取引导块的问题时,这将十分有用。

运行 memtest86+ 。这有助于检查内存是否正常工作且没有错误。

默认的文件系统为 ext4。当选择 ext4 或 xfs 时使用逻辑卷管理器 (LVM)。还可以设置限制 LVM 空间的其它选项(详见 下文)。

Proxmox VE 可以安装在 ZFS 上,因此 ZFS 为没有硬件 RAID 控制器的系统提供了多种软 RAID 标准可供选择,必须在 Options(选项) 对话框中选择对应的目标磁盘(见右图)。可以在 Advanced Options(高级选项) 中找到更多 ZFS 相关的细节设置 (详见 下文)。

|

|

ZFS 不支持任何硬件 RAID,且会导致数据丢失。 |

密码长度至少 12 到 14 字符。

包括小写和大写的字母字符、数字和符号。

避免字符重复、键盘范例、常用字典单词、字母或数字序列、用户名、亲戚或宠物名字、与浪漫相关联的(当前或过去)和个人信息(例如身份证号码、祖姓名或日期等)。

电子邮件地址用于向系统管理员发送通知。例如:

有关可用的软件包的更新信息。

来自定期的 CRON 任务的错误消息。

下一步显示之前所选选项的摘要。重新检查每个设置,可以通过 Previous 按钮返回更改设置。接受,单击 Install 按钮。安装程序开始格式化磁盘并复制软件包到目标,请等待直到此步骤完成;然后卸下安装介质并重启系统。

更多配置通过 Proxmox 的 web 界面完成,将浏览器指向安装过程中给定的IP地址(https://youripaddress:8006)。

|

|

默认登录名为 "root" (领域为 PAM) ,密码为安装过程中指定的密码。 |

安装程序将创建名为 pve 的卷组(VG),并附加名为 root、data、swap 的逻辑卷(LV),要控制这些卷的大小,请使用:

定义要使用的总硬盘大小。通过这种方式,您可以在硬盘上保留可用空间,以便进一步分区(例如: 用于在同一硬盘上,添加可用于 LVM 存储的 PV 和 VG )。

定义 swap 卷的大小。默认值为安装的内存大小,最小 4 GB,最大 8 GB。结果值不能大于 hdsize/8 。

|

|

如果设置为 0,不会创建 swap 卷。 |

定义 root 卷的最大值,用于存储操作系统。root 卷的最大值不能大于 hdsize/4 。

定义 data 卷的最大值。data 卷的实际大小为:

datasize = hdsize - rootsize - swapsize - minfree

其中 datasize 不能大于 maxvz 。

|

|

如果是 LVM thin(精简类型的存储),仅当 datasize 大于 4GB 时才会创建 data 池 。 |

|

|

如果设置为 0,不会创建 data 卷,存储配置也将相应调整。 |

定义 LVM 卷组 pve 中剩余的可用空间量。超过 128 GB 的可用存储空间默认为 16 GB,否则将使用 hdsize/8 。

|

|

LVM 需要 VG(卷组)中的可用空间来创建快照(lvmthin 快照不需要)。 |

安装程序会创建 ZFS 池 rpool 。不会创建交换空间(swap),但您可以在安装的磁盘上为交换空间(swap)保留一些未分区的空间。您还可以在安装完成后创建一个交换空间 zvol,尽管这可能会带来问题。(请参阅 ZFS swap 说明)。

为创建的池定义 ashift 值。ashift 至少需要设置为底层磁盘的扇区大小(扇区的大小是 ashift 的 2 次方),或者可能放入池中的任何磁盘。(例如更换有缺陷的磁盘)。

定义是否为 rpool 启用压缩。

定义 rpool 应使用哪种校验和算法。

定义 rpool 的 copies 参数。查看 zfs(8) 手册页了解语义,以及为什么这不能替代磁盘级别的冗余。

定义要使用的总硬盘大小。更多的分区有助于节省硬件上的可用空间(例如创建一个交换分区)。hdsize 仅适用于可引导磁盘,即用于 RAID0、RAID1 或 RAID10 的第一个磁盘或镜像,以及 RAID-Z[123] 中的所有磁盘。

ZFS 使用大量内存时效果最好。您如果您打算使用 ZFS,请确保有足够的可用内存。一个很好的计算方法是每 1TB RAW 磁盘空间需要 4GB 加 1GB 内存。

ZFS 可以使用专用驱动器作为写缓存,称之为 ZFS Intent Log (ZIL),为它使用一个快速驱动器(SSD),可以在安装后使用以下命令添加:

# zpool add <pool-name> log </dev/path_to_fast_ssd>

以下各章节将重点介绍常见的虚拟化任务,并解释有关管理 Proxmox VE 和主机管理的细节。

Proxmox VE 是基于 Debian GNU/Linux,带有提供 Proxmox VE 相关软件包的扩展存储库。这意味着可以使用全范围内的 Debian 软件包,包括安全更新和错误修复。Proxmox VE 提供了基于 Ubuntu 内核的 Linux 内核。它开启所有必要的虚拟化和容器的功能,并包括 ZFS 和几个额外的硬件驱动程序。

对于以下章节未包含的其它主题,请参阅 Debian 文档。Debian 管理员手册 可在线获取,并全面介绍了 Debian 操作系统(详见 [Hertzog13])。

Proxmox VE 使用 APT 作为它的软件包管理工具,就像任何其它基于 Debian 的系统一样。

存储库是软件包的集合,它们可以用于安装新软件,但对于获取新更新也很重要。

|

|

您需要有效的 Debian 和 Proxmox 存储库才能获得最新的安全更新、错误修复和新功能。 |

APT 存储库由 /etc/apt/sources.list 文件和 /etc/apt/sources.list.d/ 中的 .list 文件中定义。

还支持基本的存储库管理,例如,启用和禁用一个存储库。

在 sources.list 文件中,每一行定义一个软件包存储库。首选源必须放在第一位,忽略空白行。一行中任意位置的 # 字符将该行的其余部分标记为注释。通过运行 apt-get update 获取存储库中的可用软件包。可以直接使用 apt-get,或者通过 GUI(节点 → 更新)安装更新。

deb http://ftp.debian.org/debian bullseye main contrib deb http://ftp.debian.org/debian bullseye-updates main contrib # 安全更新 deb http://security.debian.org/debian-security bullseye-security main contrib

Proxmox VE 提供了三种不同的软件包存储库。

这是默认、稳定和推荐的存储库,可供所有 Proxmox VE 的订阅用户使用。它包含最稳定的软件包,适合生产用途。默认情况下,已启用 pve-enterprise 存储库:

deb https://enterprise.proxmox.com/debian/pve bullseye pve-enterprise

用户 root@pam 会通过邮件收到关于可用更新的通知。单击 GUI 中的 变更日志 按钮,可以查看所选更新的更多详细信息。

您需要有效的订阅密钥才能访问 pve-enterprise 存储库。提供不级别的支持,更多详细信息可以在 https://www.proxmox.com/en/proxmox-ve/pricing 找到。

|

|

您可以通过使用 #(在行的开头)注释掉上面的行来禁用此存储库。如果您没有订阅密钥,这可以防止出现错误消息。在这种情况下,请配置 pve-no-subscription 存储库。 |

这是推荐用于测试和非生产用途的存储库。它的软件包没有经过严格的测试和验证。您不需要订阅密钥即可访问 pve-no-subscription 存储库。

我们建议在 /etc/apt/sources.list 中配置此存储库。

deb http://ftp.debian.org/debian bullseye main contrib deb http://ftp.debian.org/debian bullseye-updates main contrib # PVE pve-no-subscription 存储库由 proxmox.com 提供, # 不推荐用于生产用途。 deb http://download.proxmox.com/debian/pve bullseye pve-no-subscription # 安全更新 deb http://security.debian.org/debian-security bullseye-security main contrib

该存储库包含最新的软件包,主要供开发人员用于测试新功能。要配置它,请将以下行添加到 etc/apt/sources.list:

deb http://download.proxmox.com/debian/pve bullseye pvetest

|

|

此 pvetest 存储库应该(顾名思义)仅用于测试新功能或错误修复。 |

|

| Ceph Pacific (16.2) 已表明在 Proxmox VE 7.0 中很稳定。 |

此存储库包含主要的 Proxmox VE Ceph Pacific 软件包。它们适用于生产,如果您在 Proxmox VE 上运行 Ceph 客户端或完整的 Ceph 集群,请使用此存储库。

deb http://download.proxmox.com/debian/ceph-pacific bullseye main

这个 Ceph 存储库包含被移动到主存储库前的 Ceph Pacific 软件包,它用于在 Proxmox VE 上测试新的 Ceph 版本。

deb http://download.proxmox.com/debian/ceph-pacific bullseye test

|

| Ceph Octopus (15.2) 已表明在 Proxmox VE 6.3 中很稳定,它将继续在 6.x 版本的剩余生命周期 以及 Proxmox VE 7.x 中获得更新,直到 Ceph Octopus 上游版本的项目结束(EOL 到 2022-07)。 |

此存储库包含主要的 Proxmox VE Ceph Octopus 软件包。它们适用于生产,如果您在您在 Proxmox VE 上运行 Ceph 客户端或完整的 Ceph 集群,请使用此存储库。

deb http://download.proxmox.com/debian/ceph-octopus bullseye main

请注意,在较旧的 Proxmox VE 6.x 版本上,您需要把上面存储库的规则中的 bullseye 更改为 buster。

这个 Ceph 存储库包含被移动到主存储库前的 Ceph 软件包,它用于在 Proxmox VE 上测试新的 Ceph 版本。

deb http://download.proxmox.com/debian/ceph-octopus bullseye test

存储库中的 Release 文件使用 GnuPG 签名。APT 使用这些签名来验证所有软件包是否来自一个可信的源。

如果您从官方 ISO 映像安装 Proxmox VE,则已安装验证密钥。

如果您在 Debian 上安装 Proxmox VE,请使用以下命令下载并安装密钥:

# wget https://enterprise.proxmox.com/debian/proxmox-release-bullseye.gpg -O /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg

随后使用命令行(CLI)工具 sha512sum 来验证校验值:

# sha512sum /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg 7fb03ec8a1675723d2853b84aa4fdb49a46a3bb72b9951361488bfd19b29aab0a789a4f8c7406e71a69aabbc727c936d3549731c4659ffa1a08f44db8fdcebfa /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg

或者使用命令行(CLI)工具 md5sum :

# md5sum /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg bcc35c7173e0845c0d6ad6470b70f50e /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg

Proxmox 定期为所有存储库提供更新。要安装更新,可以使用基于 Web 的 GUI 或者下列的命令行(CLI)命令:

# apt-get update # apt-get dist-upgrade

|

|

APT 软件包管理系统非常灵活并提供了许多功能,请参阅 man apt-get 或者通过 [Hertzog13] 获取更多信息。 |

|

|

定期更新对于获取最新补丁和与安全相关的修复至关重要。主要系统升级会在 Proxmox VE 社区论坛 中宣布。 |

网络配置可以通过 GUI 或手动编辑包含整个网络配置的文件 /etc/network/interfaces 来完成。接口(5) 手册页包含完整的格式说明。虽然所有 Proxmox VE 工具都努力保持用户的直接修改,但使用 GUI 更适合,因为它可以保护您免受错误的影响。

配置网络后,您可以使用 Debian 的传统工具 ifup 和 ifdown 命令启动和关闭网络接口。

Proxmox VE 不会直接将更改写入 /etc/network/interfaces。相反,我们将写到名为 /etc/network/interfaces.new 的临时文件, 这样,您可以同时进行许多相关的更改,还允许在应用之前确保您的更改是正确的,因为错误的网络配置可能导致节点无法访问。

使用默认安装的 ifupdown 网络管理软件包,您需要重启才能提交任何挂起的网络更改。多数情况下,Proxmox VE 基本的网络设置很稳定且无需经常更改,因此也无需经常重启。

使用可选的 ifupdown2 网络管理软件包,您可以实时重载网络配置,而无需重启。

从 Proxmox VE 6.1 开始,您可以通过 web 界面,使用节点的 网络 面板中的 应用配置 按钮,应用挂起的网络更改。

安装 ifupdown2 前确保您已经安装了最新的 Proxmox VE 更新。

|

|

安装 ifupdown2 时将会移除 ifupdown,但是,由于 0.8.35+pve1 版本之前的 ifupdown 的移除脚本存在一个问题,即移除 [引用于 Debian Buster:https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=945877] 时网络会完全停止,因此,您 必须 确保具有最新的 ifupdown 软件包版本。 |

然后您可以简单地执行以下操作进行安装:

apt install ifupdown2

万事具备,如果您遇到问题,可随时切换回 ifupdown 。

我们目前对设备名称使用以下命名约定:

以太网设备:en*, systemd 网络接口名称。此命名方案用于 5.0 版以后的全新安装的 Proxmox VE。

以太网设备:eth[N], 其中 0 ≤ N (eth0, eth1, …) ,此命名方案用于 5.0 版本之前安装的 Proxmox VE 主机,当升级到 5.0 版本时,名称保持原样。

Bridge 名称:vmbr[N], 其中 0 ≤ N ≤ 4094 (vmbr0 - vmbr4094)

Bond(绑定):bond[N], 其中 0 ≤ N (bond0, bond1, …)

VLAN:只需将 VLAN 编号添加到设备名称中,以句点分隔。(eno1.50, bond1.30)

这使得调试网络问题变得更容易,因为设备名称表明了设备类型。

Systemd 通过两个字符前缀 en 表明以太网网络设备。下一个字符则取决于设备驱动和哪个方案优先匹配的事实。

o<index>[n<phys_port_name>|d<dev_port>] — 板载的设备

s<slot>[f<function>][n<phys_port_name>|d<dev_port>] — 热插拔设备的 id

[P<domain>]p<bus>s<slot>[f<function>][n<phys_port_name>|d<dev_port>] — 总线设备的 id

x<MAC> — 设备的 MAC 地址

最常见的范例是:

eno1 — 是第一个板载的网卡

enp3s0f1 — 是在第 3 个 pci 总线的第 0 插槽上的第 1 个网卡设备。

有关更多信息,请参阅 可预测的网络接口名称 。

根据您当前的网络组织和资源,您可以选择桥接、路由或伪装网络设置。

在这种情况下,桥接 模型最有意义,这也是新安装 Proxmox VE 的默认模式。每个来宾系统都将有一个虚拟接口连接到 Proxmox VE 的网桥(bridge),这实际上类似于将来宾的网卡直接连接到局域网的新交换机上,而 Proxmox VE 主机则扮演交换机的角色。

对于此设置,您可以使用 桥接 或 路由 模式,具体取决于供应商允许的情况。

在这种情况下,为您的来宾系统获取输出网络访问的唯一方法是使用 伪装。对于来宾的传入网络访问,您需要配置 端口转发。

为了获得更多的灵活性,您可以配置 VLAN(IEEE 802.1q)和网络绑定,也称为“链路聚合”,这是一个建立复杂且灵活的虚拟网络的合理方式。

安装程序创建的一个名为 vmbr0 的网桥,它会连接到第一张以太网网卡。相应的配置在 /etc/network/interfaces 中,它可能如下所示:

auto lo

iface lo inet loopback

iface eno1 inet manual

auto vmbr0

iface vmbr0 inet static

address 192.168.10.2/24

gateway 192.168.10.1

bridge-ports eno1

bridge-stp off

bridge-fd 0

虚拟机表现得就像它们直接连接到物理网络一样。相反,网络认为每个虚拟机均有自己的 MAC 地址,即使只有一条网线将所有虚拟机连接到网络。

大多数主机供应商不支持上述设置。出于安全原因,一旦在单个接口上检测到多个 MAC 地址,它们就会禁用网络。

|

|

某些供应商允许您通过其管理界面注册额外的 MAC 地址。这避免了问题,但是配置起来可能比较笨拙,因为您需要为您的每个 VM 注册一个 MAC 地址。 |

您可以通过单个接口“路由”所有流量来避免该问题,这确保所以网络数据包使用相同的 MAC 地址。

auto lo

iface lo inet loopback

auto eno0

iface eno0 inet static

address 198.51.100.5/29

gateway 198.51.100.1

post-up echo 1 > /proc/sys/net/ipv4/ip_forward

post-up echo 1 > /proc/sys/net/ipv4/conf/eno1/proxy_arp

auto vmbr0

iface vmbr0 inet static

address 203.0.113.17/28

bridge-ports none

bridge-stp off

bridge-fd 0伪装允许只有一个专有 IP 地址的来宾使用主机的 IP 地址来访问网络,用于传出流量。每个传出的数据包都由 iptables 重写,以显示其来源为主机,并且相应地重写响应数据包,使其能路由到原来的发送方。

auto lo

iface lo inet loopback

auto eno1

#real IP address

iface eno1 inet static

address 198.51.100.5/24

gateway 198.51.100.1

auto vmbr0

#private sub network

iface vmbr0 inet static

address 10.10.10.1/24

bridge-ports none

bridge-stp off

bridge-fd 0

post-up echo 1 > /proc/sys/net/ipv4/ip_forward

post-up iptables -t nat -A POSTROUTING -s '10.10.10.0/24' -o eno1 -j MASQUERADE

post-down iptables -t nat -D POSTROUTING -s '10.10.10.0/24' -o eno1 -j MASQUERADE

|

|

在某些防火墙已开启的伪装设定中,传出连接可能需要连接跟踪(conntrack)区域。否则防火墙可能会阻止传出连接,因为它们更喜欢 VM 网桥的 POSTROUTING(源地址转换),而不是 MASQUERADE(地址伪装)。 |

在 /etc/network/interfaces 中添加这些行可以解决这个问题:

post-up iptables -t raw -I PREROUTING -i fwbr+ -j CT --zone 1 post-down iptables -t raw -D PREROUTING -i fwbr+ -j CT --zone 1

有关这方面的更多信息,请参阅以下链接:

Bond(绑定,也称为 NIC 组合或链路聚合)是一种将多个 NIC(网卡)绑定到单个网络设备的技术,它可以实现不同的目标,例如让网络具有容错能力、提高性能或两者兼而有之。

光纤通道等高速硬件和相关的交换硬件可能非常昂贵,通过链路聚合,将两个网卡作为一个逻辑接口,从而实现双倍的速度。这是大多数交换机都支持的 Linux 内核自带的功能。如果您的节点拥有多个以太网端口,您可以通过将网络电缆连接到不同的交换机来分散故障点,并且在网络出现故障时,绑定的连接会将故障转移到一根或另一根电缆。

聚合的链路可以改善实时迁移的延迟,并提高 Proxmox VE 集群节点之间数据复制的速度。

有 7 种绑定的模式:

轮询调度 Round-robin(balance-rr,负载均衡):传输网络数据包按顺序从可用的第一个从属(slave)网络接口(网卡)依次传输到最后一个。本模式提供负载均衡和容错的能力。

主要-备用 Active-backup(active-backup,主-备): 绑定中只有一个从属(slave)NIC 设备处于活动状态。当且当活动状态的从属(slave)设备发生故障时,另一个从属(slave)设备才会变成活动状态。为避免网络交换机发生混乱,单个逻辑绑定接口仅有一个 NIC(端口)的 MAC 地址对外可见。本模式提供容错功能。

XOR(balance-xor,均衡容错): 传输网络数据包基于 [(源 MAC 地址异或(XOR)目标 MAC 地址)%(模运算)从属(slave) NIC 的数量]。这将为每个目标 MAC 地址选择相同的从属(slave) NIC 。本模式提供负载均衡和容错的能力。

广播 (broadcast,广播): 在所有从属(slave)的网络接口中传输网络数据包。本模式提供容错功能。

IEEE 802.3ad 动态链接聚合(简称 802.3ad)(LACP): 创建可以共享相同速度和双工设置的聚合组。根据 802.3ad 规范,使用活动状态的汇聚组中的所有从属(slave)网络接口。

自适应传输负载均衡(balance-tlb): Linux 绑定驱动程序模式,不需要任何特殊的网络交换机支持。外出网络的数据包流量是按当前负载(相对于速度计算)分配到每个从属(slave)的网络接口上,传入流量由当前指定的从属(slave)网络接口进行接收,如果此接收的从属(slave)设备发生故障,则另一个从属(slave)设备接管故障的从属(slave)设备的 MAC 地址。

自适应负载均衡(balance-alb): 包括 balance-tlb 和用于 IPV4 流量的接收负载均衡(rlb),且不需要任何特殊的网络交换机支持。通过 ARP 协商实现了接收负载平衡。绑定驱动程序拦截本地系统发送的 ARP Replies(ARP 回应报文),然后把单个逻辑绑定的接口中的某个从属(slave)NIC 设备的唯一硬件地址覆盖源硬件地址,以此为不同网络节点的网络数据包流量使用不同的 MAC 地址。

如果您的交换机支持 LACP (IEEE 802.3ad) 协议,则我们建议使用相应的绑定模式(802.3ad)。除此之外,通常应该使用主-备(active-backup)模式。

如果您打算在绑定接口上运行集群网络,则您必须在绑定接口上使用主动-被动(active-passive)模式,不支持其他模式。

以下绑定配置可用作分布式/共享存储网络。这样做的好处是,您可以获得更高的速度,并且网络将具有容错能力。

auto lo

iface lo inet loopback

iface eno1 inet manual

iface eno2 inet manual

iface eno3 inet manual

auto bond0

iface bond0 inet static

bond-slaves eno1 eno2

address 192.168.1.2/24

bond-miimon 100

bond-mode 802.3ad

bond-xmit-hash-policy layer2+3

auto vmbr0

iface vmbr0 inet static

address 10.10.10.2/24

gateway 10.10.10.1

bridge-ports eno3

bridge-stp off

bridge-fd 0auto lo

iface lo inet loopback

iface eno1 inet manual

iface eno2 inet manual

auto bond0

iface bond0 inet manual

bond-slaves eno1 eno2

bond-miimon 100

bond-mode 802.3ad

bond-xmit-hash-policy layer2+3

auto vmbr0

iface vmbr0 inet static

address 10.10.10.2/24

gateway 10.10.10.1

bridge-ports bond0

bridge-stp off

bridge-fd 0一个虚拟局域网(VLAN)是一个广播域,它在二层网络进行分区和隔离。因此,在一个物理网络中可能有多个网络(4096 个),每个网络相互独立。

每个 VLAN 网络使用一个通常称为 标签(tag) 的数字进行标识。然后,给网络数据包 打标签(tagged) 以识别它们属于哪个虚拟网络。

Proxmox VE 支持这种开箱即用的设置。您可以在创建 VM 时指定 VLAN 标签,则此 VLAN 标签是来宾网络配置的一部分。网络层支持不同的模式来实现 VLAN,具体取决于桥接(bridge)的配置:

在 Linux bridge 上的 VLAN 感知:在这种情况下,每个来宾的虚拟网卡都分配了一个 VLAN 标签,Linux bridge(网桥) 支持透明传递标签。中继模式(Trunk)也是可能的,但这需要在来宾中进行配置。

在 Linux bridge 上的 "传统" VLAN:与 VLAN 感知方法相比,此方法不是透明的,而是为每个 VLAN 创建一个具有关联网桥的 VLAN 设备。也就是说,例如在 VLAN 5 上创建一个来宾,将创建两个接口 eno1.5 和 vmbr0v5,它们将一直保留到重新启动。

Open vSwitch VLAN:此模式使用 OVS VLAN 功能。

来宾配置的 VLAN:VLAN 是在来宾内部分配的。在这种情况下,设置在来宾内部完成且不受外部影响。优势是您可以在单个虚拟网卡上使用多个 VLAN 。

允许主机与隔离网络通信。可以将 VLAN 标签应用于任何网络设备(网卡、Bond(绑定)、Bridge(网桥))。通常,您应该在接口上配置 VLAN,使其与物理网卡之间有最少的抽象层。

例如,在默认配置中,您希望将主机管理地址放置在单独的 VLAN 上。

auto lo

iface lo inet loopback

iface eno1 inet manual

iface eno1.5 inet manual

auto vmbr0v5

iface vmbr0v5 inet static

address 10.10.10.2/24

gateway 10.10.10.1

bridge-ports eno1.5

bridge-stp off

bridge-fd 0

auto vmbr0

iface vmbr0 inet manual

bridge-ports eno1

bridge-stp off

bridge-fd 0

auto lo

iface lo inet loopback

iface eno1 inet manual

auto vmbr0.5

iface vmbr0.5 inet static

address 10.10.10.2/24

gateway 10.10.10.1

auto vmbr0

iface vmbr0 inet manual

bridge-ports eno1

bridge-stp off

bridge-fd 0

bridge-vlan-aware yes

bridge-vids 2-4094

下一个范例是相同的设置,但使用了一个 bond(绑定)来确保网络具有容错性。

auto lo

iface lo inet loopback

iface eno1 inet manual

iface eno2 inet manual

auto bond0

iface bond0 inet manual

bond-slaves eno1 eno2

bond-miimon 100

bond-mode 802.3ad

bond-xmit-hash-policy layer2+3

iface bond0.5 inet manual

auto vmbr0v5

iface vmbr0v5 inet static

address 10.10.10.2/24

gateway 10.10.10.1

bridge-ports bond0.5

bridge-stp off

bridge-fd 0

auto vmbr0

iface vmbr0 inet manual

bridge-ports bond0

bridge-stp off

bridge-fd 0

Proxmox VE 集群堆栈(stack)本身在很大程度上依赖一个事实:所有节点都精确地同步了时间。如果所有节点上的本地时间不同步,其他一些组件(如 Ceph)也将无法正常工作。

使用“网络时间协议”(简称 NTP)可以实现节点之间的时间同步。从 Proxmox VE 7 开始,chrony 被用作默认的 NTP 守护进程,而 Proxmox VE 6 使用 systemd-timesyncd。两者都预先配置为使用一组公共服务器。

|

|

如果您将系统升级到 Proxmox VE 7,建议手动安装 chrony、ntp 或 openntpd。 |

在某些情况下,可能需要使用非默认的 NTP 服务器。例如,如果您的 Proxmox VE 节点受限于防火墙策略而未能访问公共互联网,则您需要设置本地 NTP 服务器并告知 NTP 守护进程使用它们。

应在 /etc/chrony/chrony.conf 中为 chrony 指定使用哪些服务器:

server ntp1.example.com iburst server ntp2.example.com iburst server ntp3.example.com iburst

重启 chrony:

# systemctl restart chronyd

检查日志以确认正在使用新配置的 NTP 服务器:

# journalctl --since -1h -u chrony

... Aug 26 13:00:09 node1 systemd[1]: Started chrony, an NTP client/server. Aug 26 13:00:15 node1 chronyd[4873]: Selected source 10.0.0.1 (ntp1.example.com) Aug 26 13:00:15 node1 chronyd[4873]: System clock TAI offset set to 37 seconds ...

应在 /etc/systemd/timesyncd.conf 中为 systemd-timesyncd 指定使用哪些服务器:

[Time] NTP=ntp1.example.com ntp2.example.com ntp3.example.com ntp4.example.com

然后,重启同步服务(systemctl restart systemd-timesyncd),并通过检查日志(journalctl --since -1h -u systemd-timesyncd)来验证新配置的 NTP 服务器是否正在使用中:

... Oct 07 14:58:36 node1 systemd[1]: Stopping Network Time Synchronization... Oct 07 14:58:36 node1 systemd[1]: Starting Network Time Synchronization... Oct 07 14:58:36 node1 systemd[1]: Started Network Time Synchronization. Oct 07 14:58:36 node1 systemd-timesyncd[13514]: Using NTP server 10.0.0.1:123 (ntp1.example.com). Oct 07 14:58:36 node1 systemd-timesyncd[13514]: interval/delta/delay/jitter/drift 64s/-0.002s/0.020s/0.000s/-31ppm ...

目前支持的有:

Graphite (详见 https://graphiteapp.org )

InfluxDB (详见 https://www.influxdata.com/time-series-platform/influxdb/ )

外部度量服务器的定义保存在 /etc/pve/status.cfg,并可通过 Web 界面进行编辑。

默认情况下,Proxmox VE 通过 UDP 发送数据,因此需要将 graphite 服务器配置为接受该数据。此处最大传输单元(MTU)可以配置为不使用标准 1500 MTU 的环境。

您还可以配置插件来使用 TCP,为了不阻塞重要的 pvestatd 统计数据收集守护进程,需要配置“超时”来应对网络问题。

下面是 influxdb 的范例配置(在您的 influxdb 服务器上):

[[udp]] enabled = true bind-address = "0.0.0.0:8089" database = "proxmox" batch-size = 1000 batch-timeout = "1s"

使用这个配置,您的服务器侦听端口 8089 上的所有 IP 地址,并将数据写入 proxmox 数据库。

或者,该插件可以配置为使用 InfluxDB 2.x 的 http(s) API。InfluxDB 1.8.x 版本事实上包含了一个向前兼容的 v2 版本 API 端口。

要使用它,请将 influxdbproto 设置为 http 或 https(取决于您的配置)。默认情况下,Proxmox VE 使用的“组织”和“插槽/数据库”均为 proxmox(它们可以分别配置 组织 和 插槽 进行设置 )。

由于 InfluxDB 的 v2 API 仅适用于认证,您必须生成一个令牌,这个令牌可以写入正确的插槽(bucket)并进行设置。

在 1.8.x 版本的 v2 版本兼容性 API 中,您可以使用 user:password(用户名:密码) 作为令牌(如果需要),并且可以省略 组织,因为这在 InfluxDB 1.x 中没有意义。

您还可以通过 超时 来设置 HTTP 超时的时间(默认是 1 秒),以及使用 max-body-size 来设置(这对应于同名的 InfluxDB 设置)的最大批次大小(默认为 25000000 字节)。

尽管推荐使用强健的冗余存储,但是它对监视本地磁盘的健康也非常有帮助。

从 Proxmox VE 4.3 开始,必须要安装 smartmontools

[smartmontools 主页 https://www.smartmontools.org]

软件包。这是一组用于监视和控制本地硬盘的 S.M.A.R.T 系统的工具。

您可以通过发出以下命令来获取磁盘的状态:

# smartctl -a /dev/sdX

其中 /dev/sdX 是一个本地磁盘的路径。

如果输出显示:

# SMART 支持:已禁用

SMART support is: Disabled

您可以使用以下命令启用它:

# smartctl -s on /dev/sdX

有关如何使用 smartctl 的更多信息,请参阅 man smartctl。

默认情况下,smartmontools 的守护进程 smartd 处于活动状态并启用,每 30 分钟扫描一次 /dev/sdX 和 /dev/hdX 下的磁盘,以查找错误和警告,并在检测到问题时向管理员(root)发送电子邮件。

有关如何配置 smartd 的更多信息,请参阅 man smartd 和 man smartd.conf。

如果您将硬盘和硬件 RAID 控制器一起使用,有许多类似的工具可以监视 RAID 阵列里的磁盘和阵列本身。有关这方面的更多信息,请参阅 RAID 控制器的供应商。

大多数人直接在本地磁盘上安装 Proxmox VE 。Proxmox VE 的安装 CD 为本地磁盘管理提供了多个选项,当前的默认设置使用 LVM 。安装程序允许您为此类设置选择单个磁盘,并将该磁盘作为卷组(VG)( Volume Group)pve 的物理卷。以下输出是来自使用小容量的 8GB 磁盘的测试安装:

# pvs PV VG Fmt Attr PSize PFree /dev/sda3 pve lvm2 a-- 7.87g 876.00m # vgs VG #PV #LV #SN Attr VSize VFree pve 1 3 0 wz--n- 7.87g 876.00m

安装程序在此 VG 内分配了三个逻辑卷(LV)(Logical Volumes):

# lvs LV VG Attr LSize Pool Origin Data% Meta% data pve twi-a-tz-- 4.38g 0.00 0.63 root pve -wi-ao---- 1.75g swap pve -wi-ao---- 896.00m

格式为 ext4,并包含操作系统。

交换(Swap)分区

此卷使用 LVM-thin,并用来存储 VM 映像。LVM-thin 更适合此任务,因为它提供了对快照和克隆的高效率支持。

对于 4.1 版本之前的 Proxmox VE,安装程序创建一个名为 “data” 的标准逻辑卷(LV),该卷挂载在 /var/lib/vz。

从 4.2 版本开始,逻辑卷 “data” 是一个 LVM-thin pool(LVM 精简配置池),用于存储 基于块(block)的 来宾映像,而 /var/lib/vz 只是 root 文件系统上的一个目录。

我们强烈建议对此类设置使用硬件 RAID 控制器(带 BBU)。这会提高性能、提供冗余并使更换磁盘更容易(可热插拔)。

LVM 本身不需要任何特殊的硬件,且对内存的要求很低。

我们默认安装了两个引导加载程序。第一个分区包含标准的 GRUB 引导加载程序,第二个分区是一个 EFI 系统分区(EFI System Partition (ESP 分区) ), 它可以在 EFI 系统上启动。

假设我们有一个空磁盘 /dev/sdb,我们想在其上创建一个名为“vmdata”的卷组(VG)。

|

|

请注意,以下命令将销毁 /dev/sdb 上的所有现有数据。 |

首先创建一个分区。

# sgdisk -N 1 /dev/sdb

创建一个无需确认和 250K 元数据大小的物理卷(PV)(Physical Volume)。

# pvcreate --metadatasize 250k -y -ff /dev/sdb1

在 /dev/sdb1 上创建一个名为“vmdata” 的卷组(VG)。

# vgcreate vmdata /dev/sdb1

这可以通过创建一个新的精简逻辑卷(Thin LV)来轻松完成。

# lvcreate -n <Name> -V <Size[M,G,T]> <VG>/<LVThin_pool>

一个真实的例子:

# 在 pve 卷组中的 data 精简配置池中创建一个名为 vz,容量 10G 的逻辑卷(LV)。

# lvcreate -n vz -V 10G pve/data

现在必须在名为 vz 的逻辑卷(LV)上创建一个文件系统。

# mkfs.ext4 /dev/pve/vz

最后必须要挂载它才能使用。

|

|

确保 /var/lib/vz 为空,在默认安装中它不是空的。 |

要使其始终可访问,请在 /etc/fstab 中添加以下行。

# echo '/dev/pve/vz /var/lib/vz ext4 defaults 0 2' >> /etc/fstab

可以通过以下命令调整逻辑卷(LV)和元数据池(pool)的大小:

# lvresize --size +<size[\M,G,T]> --poolmetadatasize +<size[\M,G]> <VG>/<LVThin_pool>

|

|

在扩展数据池时,也必须扩展元数据池。 |

必须在卷组(VG)上创建精简池(thin pool)。如何创建卷组(VG)请参阅 逻辑卷管理(LVM)的 创建卷组(VG)章节。

# lvcreate -L 80G -T -n vmstore vmdata

ZFS 是由 Sun Microsystems 设计的组合文件系统和逻辑卷(LV)管理器。从 Proxmox VE 3.4 开始,ZFS 文件系统作为原生 Linux 内核引入的可选文件系统,同样也作为 root 文件系统的附加选择。无需手动编译 ZFS 模块 - 所有软件包已包含在内。

通过使用 ZFS,不仅可以利用低预算硬件实现最大的企业功能,还可以利用 SSD 缓存甚至仅用 SSD 设置来实现高性能的系统。ZFS 可以通过适度的 CPU、内存负载并结合轻松的管理来代替成本高昂的硬件 RAID 卡。

通过 Proxmox VE GUI 界面和命令行(CLI)轻松配置和管理。

可靠

防止数据损坏

文件系统级别的数据压缩

快照

写时复制克隆

不同 RAID 级别:RAID0,RAID1,RAID10,RAIDZ-1,RAIDZ-2 和 RAIDZ-3

可用 SSD 作为缓存

自我修复

持续完整性检查

专为高存储容量而设计

网络异步复制

开源

加密

…

ZFS 严重依赖 内存,因此您至少需要 8GB 内存才能启动。在实践中,尽可能多地使用您的硬件/预算。为防止数据损坏,我们建议使用高品质的 ECC 内存。

如果您使用专用缓存和[/或]日志磁盘,则应该使用企业级的 SSD(例如 Intel SSD DC S3700 系列),这可以显著提高整体性能。

|

|

不要在自带缓存管理的硬件 RAID 上使用 ZFS,因为 ZFS 需要直接与磁盘通信,所以 HBA 适配器或者类似将固件更新为 “IT”模式(flashed IT mode)的 LSI 控制器更适合。 |

如果您正尝试在 VM 中安装 Proxmox VE(嵌套虚拟化),请不要为该 VM 的磁盘使用 virtio,这是由于 ZFS 不支持它们,可以改用 IDE 或 SCSI(也适用于 virtio SCSI 控制器类型)。

当您使用 Proxmox VE 安装程序进行安装时,您可以选择 ZFS 作为 root 文件系统,您需要在安装时选择 RAID 类型:

| RAID0 |

也称为“条带”。该卷的容量是所有磁盘容量的总和。但是 RAID0 并未添加任何冗余,因此单个驱动器的故障会导致卷无法使用。 |

| RAID1 |

也称为“镜像”。数据以相等的方式写入所有磁盘。此模式至少需要 2 个相同大小的磁盘,产生的容量是单个磁盘的容量。 |

| RAID10 |

RAID0 和 RAID1 的组合。至少需要 4 个磁盘。 |

| RAIDZ-1 | RAID-5 的变体之一,单奇偶校验,至少需要 3 个磁盘。 |

| RAIDZ-2 | RAID-5 的变体之一,双奇偶校验,至少需要 4 个磁盘。 |

| RAIDZ-3 | RAID-5 的变体之一,三重奇偶校验,至少需要 5 个磁盘。 |

安装程序会自动对磁盘进行分区,创建一个名为 rpool 的 ZFS 池,并在 ZFS 子卷 rpool/ROOT/pve-1 上安装 root 文件系统。

创建另一个名为 rpool/data 的子卷用于存储 VM 映像。为了与 Proxmox VE 工具一起使用,安装程序在 /etc/pve/storage.cfg 文件中创建下列配置条目:

zfspool: local-zfs

pool rpool/data

sparse

content images,rootdir安装以后,您可以使用 zpool 命令查看 ZFS 池状态:

# zpool status

pool: rpool

state: ONLINE

scan: none requested

config:

NAME STATE READ WRITE CKSUM

rpool ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

sda2 ONLINE 0 0 0

sdb2 ONLINE 0 0 0

mirror-1 ONLINE 0 0 0

sdc ONLINE 0 0 0

sdd ONLINE 0 0 0

errors: No known data errorszfs 命令用于配置和管理您的 ZFS 文件系统。以下命令列出安装完成后的所有文件系统:

# zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 4.94G 7.68T 96K /rpool rpool/ROOT 702M 7.68T 96K /rpool/ROOT rpool/ROOT/pve-1 702M 7.68T 702M / rpool/data 96K 7.68T 96K /rpool/data rpool/swap 4.25G 7.69T 64K -

在选择 ZFS 池(ZFS pool)的布局时,需要考虑几个因素。ZFS 池的基本构建块(block)是虚拟设备或叫 vdev(虚拟设备)。在池中的所有的 vdev 均等使用,并且数据之间进行条带化处理(RAID0)。查看 zpool(8) 手册页以了解关于 vdev 的更多详细信息。

每种 vdev 类型都有不同的性能表现。感兴趣的两个参数是 IOPS(Input/Output Operations per Second,即每秒输入/输出操作的次数)和数据读取或写入的带宽。

在写入数据时,镜像 的 vdev (RAID1) 在这两个参数方面的表现与单个磁盘相似,而在读取数据时,其表现类似于镜像中的磁盘数。

一个常见的情况是有 4 个磁盘。当将其设置为 2 个镜像的 vdev(RAID10)时,该 pool 将在 IOPS 和带宽方面具有两个单磁盘的写入特性。对于读取操作,它将类似于 4 个单磁盘。

就具有大量带宽的 IOPS 而言,任何冗余级别的 RAIDZ 都近似于单个磁盘,至于多少带宽则取决于 RAIDZ 的 vdev 的容量大小和冗余级别。

对于正在运行的 VM ,在大多数情况下,IOPS 是很重要的指标。

虽然由 镜像 的 vdev 组成的池(pool)将具有最佳的性能特性,但是可用空间将只有可用磁盘的 50%,如果镜像的 vdev 包括 2 个以上的磁盘,可用空间将会更少(例如在一个 3-way 镜像中)。每个镜像至少需要一个运行状况良好的磁盘才能使池(pool)保持正常运行。

N 个磁盘的 RAIDZ 类型的 vdev 的可用空间大致为 N-P(N 减去 P),P 对应 RAIDZ 的级别(RAIDZ-级别)。RAIDZ 的级别表明在不丢失数据的情况下允许发生故障的任意磁盘数量。一种特殊情况是使用 RAIDZ2 的 4 个磁盘池,在这种情况下,通常最好使用 2 个镜像的 vdev 以获得更好的性能,因为可用空间将是相同的。

使用任何 RAIDZ 级别时另一个重要因素是用于 VM 磁盘的 ZVOL 数据集的行为方式。对于每个数据块(block),池需要奇偶校验数据,该数据大小至少是池定义的 ashift 值最小的块尺寸的大小,当 ashift 为 12 时,池的块尺寸是 4k。ZVOL 的默认块尺寸为 8k。因此,在 RAIDZ2 中,每写入 8k 的块同时会写入两个额外的 4k 奇偶校验块,8k + 4k + 4k = 16k 。当然这是一种简化的方法,实际情况会略有不同,在本例中未将元数据、是否压缩等考虑在内。

当检查 ZVOL 的以下属性时可以观察到此行为:

volsize

refreservation(如果池未进行精简配置)

used(如果池是精简配置且不存在快照)

# zfs get volsize,refreservation,used <pool>/vm-<vmid>-disk-X

volsize 是提供给 VM 的磁盘大小,而 refreservation 显示池(pool)上的保留空间,其中包括奇偶校验数据所需的预期空间。如果池(pool)是精简配置的,则 refreservation 将设置为 0。观察该行为的另一种方法是比较 VM 中的已用磁盘空间和已使用属性。请注意,快照会影响该值的准确性。

有几个选项可提高空间利用率:

增加 volblocksize(卷-块尺寸),以改善数据进行奇偶检验的比率。

使用 镜像 的 vdev,而不是 RAIDZ。

使用 ashift=9(块大小为 512 字节)。

volblocksize(卷-块尺寸) 属性只能在创建 ZVOL 时设置。可以在存储配置中更改默认值。执行此操作时,来宾(虚拟机)需要根据用例进行相应的调整,如果只是从 ZFS 层级移动到来宾(虚拟机),则会出现写入放大的问题。

在创建池时使用 ashift=9 会导致性能不佳,具体取决于下面的磁盘,并且以后无法更改。

镜像的 vdev(RAID1、RAID10)对于 VM 的工作负载具有良好的表现。除非您的环境具有 RAIDZ 可接受的特定需求与特征,否则请使用它们。

Proxmox VE 使用 proxmox-boot-tool 来管理引导加载程序(bootloader)配置。有关详细信息,请参阅 Proxmox VE 主机 bootloader(引导加载程序) 一章。/p>

本节为您提供了一些常见任务的使用范例。ZFS 本身非常强大,并提供了许多选项。管理 ZFS 的主要命令是 zfs 和 zpool。这两个命令都带有很棒的手册页,可以通过以下方式阅读:

# man zpool # man zfs

要创建一个新池(pool),至少需要一个磁盘。ashift 应与底层磁盘具有相同(ashift 的 2 次方)或更大的扇区大小。

# zpool create -f -o ashift=12 <pool> <device>

激活压缩(参阅 ZFS 中的压缩 部分):

# zfs set compression=lz4 <pool>

至少 1 个磁盘

# zpool create -f -o ashift=12 <pool> <device1> <device2>

至少 2 个磁盘

# zpool create -f -o ashift=12 <pool> mirror <device1> <device2>

至少 4 个磁盘

# zpool create -f -o ashift=12 <pool> mirror <device1> <device2> mirror <device3> <device4>

至少 3 个磁盘

# zpool create -f -o ashift=12 <pool> raidz1 <device1> <device2> <device3>

至少 4 个磁盘

# zpool create -f -o ashift=12 <pool> raidz2 <device1> <device2> <device3> <device4>

可以使用专用缓存驱动器分区来提高性能(使用SSD)。

比如 <device>,可以使用更多设备,就如“使用 RAID* 创建新池”中所示。

# zpool create -f -o ashift=12 <pool> <device> cache <cache_device>

可以使用专用缓存驱动器分区来提高性能(使用SSD)。

比如 <device>,可以使用更多设备,就如“使用 RAID* 创建新池”中所示。

# zpool create -f -o ashift=12 <pool> <device> log <log_device>

如果您有一个没有缓存和日志的池。使用 parted 或 gdisk 将 SSD 分成 2 个分区。

|

| 始终使用 GPT 分区表。 |

日志设备的最大大小应该是物理内存大小的一半左右,所以这通常很小。SSD 的其余部分可用作缓存。

# zpool add -f <pool> log <device-part1> cache <device-part2>

# zpool replace -f <pool> <old device> <new device>

根据 Proxmox VE 的安装方式,它使用 proxmox-boot-tool

[安装有 Proxmox VE 6.4 或更高版本的系统,安装有 Proxmox VE 5.4 或更高版本的 EFI 系统]

或简单的 grub 作为 bootloader(引导加载程序)(参阅 主机 Bootloader(引导加载程序))。您可以通过运行以下命令来检查:

# proxmox-boot-tool status

第一步都是相同的,包括复制分区表、重新发布 GUID 和替换 ZFS 分区。为了让系统可以从全新磁盘引导,需要根据所使用的 bootloader(引导加载程序) 来执行不同的步骤。

# sgdisk <healthy bootable device> -R <new device> # sgdisk -G <new device> # zpool replace -f <pool> <old zfs partition> <new zfs partition>

|

|

使用 zpool status -v 命令监控新磁盘的恢复过程的进展情况。 |

# proxmox-boot-tool format <new disk's ESP> # proxmox-boot-tool init <new disk's ESP>

|

|

ESP 代表 EFI 系统分区,该分区从 5.4 版本起,由 Proxmox VE 安装程序在可引导磁盘上设置为第 2 个分区。有关详细信息,请参阅 设置新分区以用作同步 ESP。 |

# grub-install <new disk>

ZFS 附带一个事件守护进程,它监视 ZFS 内核模块生成的事件。此守护进程还能发送有关 ZFS 事件(类似池错误)的电子邮件。较新的 ZFS 软件包在单独的软件包中提供守护进程,您可以使用 apt-get 安装:

# apt-get install zfs-zed

要激活守护进程,需要使用您喜欢的编辑器编辑 /etc/zfs/zed.d/zed.rc,并取消 ZED_EMAIL_ADDR 设置的注释:

ZED_EMAIL_ADDR="root"

请注意 Proxmox VE 将邮件转发到为 root 用户配置的电子邮件地址。

|

|

唯一需要的设置是 ZED_EMAIL_ADDR,所有其他设置都是可选的。 |

默认情况下,ZFS 将 50% 的主机内存用于自适应替换缓存(ARC)(Adaptive Replacement Cache)。为 ARC 分配足够的内存对于 IO 性能至关重要,因此请谨慎减少内存。作为一般经验法则,至少分配 2GB 内存 + 每 1TB 存储用 1G 内存。例如,如果您有一个具有 8TB 可用存储空间的池,则您应该为 ARC 使用 10GB(=2G+1G*8)内存。

您可以通过以下命令,直接写入 zfs_arc_max 模块参数来更改当前引导(重新启动会再次重置此更改)的 ARC 使用限制:

echo "$[10 * 1024*1024*1024]" >/sys/module/zfs/parameters/zfs_arc_max

要 永久更改 ARC 限制,请将以下行添加到 /etc/modprobe.d/zfs.conf:

options zfs zfs_arc_max=8589934592

此范例设置将内存使用限制为 8GB(8 * 230)。

|

|

如果您想要的 zfs_arc_max 值小于或等于 zfs_arc_min(默认为系统内存的 1/32),除非您设置zfs_arc_min 至多到 zfs_arc_max - 1,否则 zfs_arc_max 将被忽略。 |

echo "$[8 * 1024*1024*1024 - 1]" >/sys/module/zfs/parameters/zfs_arc_min echo "$[8 * 1024*1024*1024]" >/sys/module/zfs/parameters/zfs_arc_max

此范例设置(临时)在总内存超过 256GB 的系统上将内存的使用限制为 8GB(8 * 230) ,其中仅设置 zfs_arc_max 是不起作用的。

|

|

如果您的 root 文件系统是 ZFS,则每次此值更改时,必须更新您的 initramfs: # update-initramfs -u 您 必须重启 才能激活这些更改。 |

在 zvol 上创建交换空间(Swap-space)可以会产生一些问题,例如阻塞服务器或产生高 IO 负载,这在开始备份到外部存储时经常看到。

我们强烈建议使用足够的内存,这样您通常不会遇到内存不足的情况。如果您需要(或想要)添加 swap(交换),最好在物理磁盘上创建一个分区,并将其用作交换(swap)设备,您可以在 安装程序 的 高级选项 中为此留出一些空间。此外,您可以降低“swappiness”的值,服务器的最佳值为 10:

# sysctl -w vm.swappiness=10

要使 swappiness 持久化,请使用您选择的编辑器打开 /etc/sysctl.conf,并添加以下行:

vm.swappiness = 10

| 值 | 策略 |

|---|---|

vm.swappiness = 0 | 内核仅交换(swap)以避免 out of memory(内存不足) 的情况。 |

vm.swappiness = 1 | 不完全禁用的最小交换量。 |

vm.swappiness = 10 | 当系统内存充足时,有时建议使用此值来提高性能。 |

vm.swappiness = 60 |

默认值 |

vm.swappiness = 100 | 内核将积极交换。 |

Linux 0.8.0 版上的 ZFS 引入了对数据集原生加密的支持。Linux 版本中的旧版 ZFS 升级以后,可以为每个池启用加密功能:

# zpool get feature@encryption tank NAME PROPERTY VALUE SOURCE tank feature@encryption disabled local # zpool set feature@encryption=enabled # zpool get feature@encryption tank NAME PROPERTY VALUE SOURCE tank feature@encryption enabled local

|

|

目前不支持使用 Grub 从具有已加密数据集的池启动,并且仅有限支持在启动时自动解锁已加密数据集。没有加密支持的旧版本 ZFS 将无法解密存储的数据。 |

|

|

建议在启动后手动解锁存储的数据集,或编写自定义单元,将启动时解锁所需的密钥材料传递给 zfs load-key 。 |

|

|

在启用生产数据的加密之前,建立并测试备份的步骤,如果相关的密钥材料/密语/密码文件已丢失,则无法再访问加密的数据。 |

创建数据集/zvol(datasets/zvols)时需要设置加密,且默认情况下子数据集会继承加密。例如,要创建加密的数据集 tank/encrypted_data,并将其配置为 Proxmox VE 中的存储,请运行以下命令:

# zfs create -o encryption=on -o keyformat=passphrase tank/encrypted_data Enter passphrase: Re-enter passphrase: # pvesm add zfspool encrypted_zfs -pool tank/encrypted_data

在此存储上创建的所有来宾的卷/磁盘,都将使用父数据集的共享密钥材料进行加密。

要实际使用存储,需要加载关联的密钥材料,并且需要挂载数据集。这可以通过以下方式一步到位:

# zfs mount -l tank/encrypted_data Enter passphrase for 'tank/encrypted_data':

通过在创建数据集时或在现有数据集上使用 zfs change-key 命令,设定 keylocation 和 keyformat 属性,就可以一个使用(随机)密钥文件来而不是提示输入密码:

# dd if=/dev/urandom of=/path/to/keyfile bs=32 count=1 # zfs change-key -o keyformat=raw -o keylocation=file:///path/to/keyfile tank/encrypted_data

|

|

使用密钥文件时,需要特别小心,以防止未经授权的访问或意外丢失密钥文件。没有密钥文件,无法访问明文数据! |

在已加密的数据集下创建的来宾(虚拟机)卷,将相应地对其 encryptionroot 属性进行设置。密钥材料仅需要每个 encryptionroot 加载一次,即可用于其下的所有加密数据集。

有关更多详细信息和高级用法,请参阅 encryptionroot、encryption、keylocation、keyformat 和 keystatus 属性,zfs load-key、zfs unload-key 和 zfs change-key 命令,以及 man zfs 的 Encryption 部分。

当对数据集启用压缩时,ZFS 会尝试在写入之前压缩所有 新 块,并在读取时解压它们。已经存在的数据(旧块)不会被追溯压缩。

您可以通过以下方式启用压缩:

# zfs set compression=<algorithm> <dataset>

我们推荐使用 lz4 算法,因为它只增加非常少的 CPU 开销。也可以用其它算法,例如 lzjb 和 gzip-N,其中 N 是从 1(最快)到 9(最佳压缩比)的整数。根据算法和数据的可压缩程度,启用压缩甚至可以提高 I/O 性能。

您可以随时通过以下命令禁用压缩:

# zfs set compression=off <dataset>

同样,只有新块会受到此更改的影响。

从 0.8.0 版本开始,ZFS 支持 专用 设备。池中的 专用 设备用于存储元数据、重复数据删除表和可选的小文件块。

一个 专用 的设备可以提高由慢速硬盘组成的池的速度,该池中包含大量“元数据更改”。例如,涉及创建、更新或删除大量文件的工作负载将受益于 专用 设备的存在。还可以将 ZFS 数据集配置为在 专用 设备上存储全部小文件,从而进一步提高性能。对 专用 设备使用快速 SSD 。

|

|

专用 设备的冗余应与池中的冗余相匹配,因为 专用 设备是整个池的故障点。 |

|

|

无法撤消添加到池中的 专用 设备! |

# zpool create -f -o ashift=12 <pool> mirror <device1> <device2> special mirror <device3> <device4>

# zpool add <pool> special mirror <device1> <device2>

ZFS 数据集阐明 special_small_blocks=<size> 属性。size(块大小)可以是 0 ,用于禁止在 专用 设备上存储小文件块;或者是 512B 到 128K 范围内的二次幂。设置属性后,将在 专用 设备上分配使用小于 size(块大小)的新文件块。

|

|

如果 special_small_blocks 的值大于或等于数据集的 recordsize(默认 128K),则 所有 数据都将写入到 专用 设备,因此要小心! |

设置池的 special_small_blocks 属性,将更改所有子 ZFS 数据集的该属性的默认值(例如,池中的所有容器都将选择小文件块)。

# zfs set special_small_blocks=4K <pool>

# zfs set special_small_blocks=4K <pool>/<filesystem>

# zfs set special_small_blocks=0 <pool>/<filesystem>

ZFS 中磁盘格式的更改仅在主要版本之间通过指定的 功能 进行。在 zpool-features(5) 手册页中详细记录了所有功能以及常规机制。

由于启用新功能会使旧版本的 ZFS 无法导入池,这需要管理员主动通过在池上运行 zpool upgrade 命令来完成(请参阅 zpool-upgrade(8) 手册页)。

除非您需要使用其中一项新功能,否则启用它们没有任何好处。

事实上,启用新功能有一些缺点:

由于在 grub 中与 ZFS 的实施不兼容,如果 rpool 上的新功能处于活动状态,则仍然使用 grub 引导的 ZFS 上的 root 系统将无法引导。

当使用旧内核启动时,系统将无法导入任何升级的池,旧内核仍然带有旧 ZFS 模块。

引导一个较旧的 Proxmox VE ISO 来修复一个非引导系统也同样不起作用。

|

|

如果系统仍然使用 grub 启动,请 不要 升级 rpool,这将使系统无法引导。这包括 Proxmox VE 5.4 之前已安装的系统,以及使用传统 BIOS 引导方式的系统启动(请参阅 如何确定 bootloader(引导加载程序))。 |

# zpool upgrade <pool>

|

|

BTRFS 目前是以 技术预览 的形式集成到 Proxmox VE。 |

BTRFS 是一个 Linux 内核原生支持的现代化写时复制的文件系统,通过数据校验和元数据,实现了例如快照、内建 RAID 和自我修复的功能。从 Proxmox VE 7.0 开始,引入 BTRFS 作为 root 文件系统的可选项。

主系统设置及传统的基于 ext4 的设置大同小异

快照

文件系统级别的数据压缩

写时复制克隆

RAID0,RAID1 和 RAID10

防止数据损坏

自我修复

Linux 内核原生支持

…

RAID 级别 5/6 具有实验性和危险性

当您使用 Proxmox VE 安装程序进行安装时,您可以选择 BTRFS 作为 root 文件系统,您需要在安装时选择 RAID 类型:

| RAID0 |

也称为“条带”。该卷的容量是所有磁盘容量的总和。但是 RAID0 并未添加任何冗余,因此单个驱动器的故障会导致卷无法使用。 |

| RAID1 |

也称为“镜像”。数据以相等的方式写入所有磁盘。此模式至少需要 2 个相同大小的磁盘,产生的容量是单个磁盘的容量。 |

| RAID10 |

RAID0 和 RAID1 的组合。至少需要 4 个磁盘。 |

安装程序会自动对磁盘进行分区,并在 /var/lib/pve/local-btrfs 上创建附加的子卷。为了与 Proxmox VE 工具一起使用,安装程序在 /etc/pve/storage.cfg 文件中创建下列配置条目:

dir: local

path /var/lib/vz

content iso,vztmpl,backup

disable

btrfs: local-btrfs

path /var/lib/pve/local-btrfs

content iso,vztmpl,backup,images,rootdir

这会明确地禁用默认的 本地 存储,转而支持附加在子卷上的 btrfs 所指定的存储条目。

btrfs 命令用于配置和管理 btrfs 文件系统,安装完成后,可以使用下列命令列出所有附加的子卷:

# btrfs subvolume list / ID 256 gen 6 top level 5 path var/lib/pve/local-btrfs

本节为您提供了一些常见任务的使用范例。

要创建 BTRFS 文件系统,可以使用 mkfs.btrfs。使用 -d 和 -m 参数,可分别用于设置元数据的配置文件和数据的配置文件。使用可选的 -L 参数,可以设置标签。

通常,以下模式均已支持:single、raid0、raid1、raid10。

在单磁盘 /dev/sdb 上创建一个使用标签 My-Storage 的 BTRFS 文件系统:

# mkfs.btrfs -m single -d single -L My-Storage /dev/sdb

或者在 /dev/sdb1 和 /dev/sdc1 这两个分区上创建一个 RAID1:

# mkfs.btrfs -m raid1 -d raid1 -L My-Storage /dev/sdb1 /dev/sdc1

然后可以手动挂载新的文件系统,例如:

# mkdir /my-storage # mount /dev/sdb /my-storage

BTRFS 也可以像任何其它挂载点一样添加到 /etc/fstab,在启动时自动挂载。建议避免使用块设备(block-device)路径,而是使用 mkfs.btrfs 命令打印的 UUID 值,尤其在 BTRFS 设置中有多个磁盘的情况下。

例如:

# ... other mount points left out for brevity # using the UUID from the mkfs.btrfs output is highly recommended UUID=e2c0c3ff-2114-4f54-b767-3a203e49f6f3 /my-storage btrfs defaults 0 0

|

|

如果没有可用的 UUID,您可以使用 blkid 工具列出块设备的所有属性。 |

然后,您可以通过执行以下命令触发第一次挂载:

mount /my-storage

下次重启后,系统在启动时将会自动完成挂载。

您可以通过 Web 界面或使用 CLI 将现有的 BTRFS 文件系统添加到 Proxmox VE,例如:

pvesm add btrfs my-storage --path /my-storage

创建一个子卷,并链接为 btrfs 文件系统中的一个路径,该路径将显示为一个常规目录。

# btrfs subvolume create /some/path

之后,/some/path 将像常规目录一样工作。

与通过 rmdir 命令删除目录相反,通过 btrfs 命令删除子卷无需为空。

# btrfs subvolume delete /some/path

BTRFS 实际上并未区分快照和普通子卷,因此生成快照也可以看作是子卷创建的任意副本。按照惯例,Proxmox VE 在创建来宾磁盘的快照或子卷的快照时将对其使用只读标志,但此标志也可以稍后更改。

# btrfs subvolume snapshot -r /some/path /a/new/path

将创建("克隆")一个 /some/path 只读的子卷到 /a/new/path,将来对 /some/path 的任何修改,都会导致修改后的数据在修改前已被复制。

如果省略只读 (-r) 选项,则两个子卷都将是可写的。

默认情况下,BTRFS 不压缩数据。要启用 压缩,可以添加压缩挂载选项。请注意,已写入的数据在事后不会被压缩。

默认情况下,将会在 /etc/fstab 中列出 rootfs(root 文件系统),如下所示:

UUID=<您的 root 文件系统的 uuid> / btrfs defaults 0 1

您可以简单地将 compress=zstd、compress=lzo 或 compress=zlib 追加到上面的 defaults 中,如下所示:

UUID=<您的 root 文件系统的 uuid> / btrfs defaults,compress=zstd 0 1

此更改将在重新启动后生效。

对于某些 btrfs 设置,经典工具 df 可能会输出令人困惑的值,要获得更好的估计值,建议使用 btrfs filesystem usage /PATH 命令,例如:

# btrfs fi usage /my-storage

Proxmox VE 节点管理工具(pvenode)允许您控制节点的特有设置和资源。

当前,pvenode 允许您设置节点的描述,在节点来宾(虚拟机)上运行各种批量操作,查看节点的任务历史记录,并管理节点的 SSL 证书,这些证书通过 pveproxy 用于 API 和 web GUI。

局域网唤醒(WoL)允许您通过发送一个魔术封包(magic packet),来启动在网络中休眠的计算机。至少需要一个 NIC 必须支持该功能,并需要在计算机的固件(BIOS/UEFI)的配置中启用相应的选项,选项的名称可以从 Enable Wake-on-Lan 变化为 Power On By PCIE Device;如果您不确定,请查阅主板的供应商手册。运行 ethtool 命令可以用来检查 <interface> 的 WoL 配置:

ethtool <interface> | grep Wake-on

pvenode 命令允许您通过 WoL 唤醒集群中休眠的节点,使用以下命令:

pvenode wakeonlan <node>

通过 UDP 的端口 9 广播 WoL 魔术封包(magic packet),其中包含从 wakeonlan 属性获得的 <node>(节点)的 MAC 地址。可以使用以下命令设置节点特有的 wakeonlan 属性:

pvenode config set -wakeonlan XX:XX:XX:XX:XX:XX

在排除服务器问题(例如,失败的备份任务)故障时,拥有之前运行的任务日志通常会有所帮助。使用 Proxmox VE,您可以通过 pvenode task 命令访问节点的任务历史记录。

您可以使用 list 子命令,获取节点中已完成任务的过滤列表。例如,要获取结束时出现错误的 VM 100 相关的任务列表,可以使用如下命令:

pvenode task list --errors --vmid 100

可以使用相应的 UPID 打印任务的日志:

pvenode task log UPID:pve1:00010D94:001CA6EA:6124E1B9:vzdump:100:root@pam:

如果您的许多 VM / 容器,可以使用 pvenode 的 startall 和 stopall 子命令批量完成启动和停止来宾的操作。默认情况下,pvenode startall 将仅能启动那些已设置为在开机自动启动的虚拟机/容器(请参阅 虚拟机的自动启动和关机),但是,您可以使用 --force 标志覆盖这个行为。这两个命令还有一个 --vms 选项,它通过指定 VMID 来限制停止/启动的来宾。

例如,要启动 VM 100、101 和 102,无论它们是否拥有 onboot 设置,都使用以下命令:

pvenode startall --vms 100,101,102 --force

要停止这些来宾以及可能正在运行的任何其它来宾,使用以下命令:

pvenode stopall

如果您的 VM / 容器依赖于启动缓慢的外部资源,例如 NFS 服务器,您还可以在 Proxmox VE 引导时间和已配置自动启动的第一台 VM /容器的引导时间之间设置每个节点的延迟。(请参阅 虚拟机的自动启动和关机)。

您可以通过以下设置来实现延迟(其中 10 表示以秒为单位的延迟):

pvenode config set --startall-onboot-delay 10

如果有升级情况需要您将所有来宾从一个节点迁移到另一个节点,pvenode 还提供 migrateall 子命令用于批量迁移。默认情况下,此命令会将系统上的每个来宾都迁移到目标节点。可以将其设置为仅迁移一组来宾。

例如,要将 VM 100、101 和 102 迁移到节点 pve2,并启用本地磁盘的实时迁移,您可以运行:

pvenode migrateall pve2 --vms 100,101,102 --with-local-disks

默认情况下,每个 Proxmox VE 集群都会创建自己的(自签名)证书颁发机构 (CA),并为每个节点生成一个由上述 CA 签名的证书。这些证书用于与集群的 pveproxy 服务和 Shell / 终端的功能(如果使用 SPICE)进行加密通信。

CA 证书和密钥存储在 Proxmox 集群文件系统 (pmxcfs) 中。

REST API 和 Web GUI 由每个节点上运行的 pveproxy 服务提供。

对于 pveproxy 使用的证书,您有以下选项:

默认情况下,使用 /etc/pve/nodes/NODENAME/pve-ssl.pem 作为节点指定的证书。此证书由集群 CA 签署,因此浏览器和操作系统不会自动信任它。

使用外部提供的证书(例如,由商业 CA 签署)。

使用 ACME(Let’s Encrypt)来获得一个自动续期的可信证书,这也已集成在 Proxmox VE API 和 Web 界面中。

对于选项 2 和 3,使用文件 /etc/pve/local/pveproxy-ssl.pem (和 /etc/pve/local/pveproxy-ssl.key,需要无密码)。

|

|

请记住,/etc/pve/local 是一个节点特定的符号链接,它指向 /etc/pve/nodes/NODENAME 。 |

通过 Proxmox VE 节点管理命令进行管理证书(请参阅 pvenode(1) 手册页)。

|

|

请勿替换或手动修改自动生成的节点证书文件(/etc/pve/local/pve-ssl.pem 和 /etc/pve/local/pve-ssl.key),或者群集 CA 文件(/etc/pve/pve-root-ca.pem 和 /etc/pve/priv/pve-root-ca.key)。 |

Proxmox VE 包含有一个 ACME(Automatic Certificate Management Environment,自动证书管理环境)协议的实现,允许 Proxmox VE 管理员使用类似 Let’s Encrypt 这样的 ACME 供应商来轻松设置 TLS 证书,这些证书在现代操作系统与 Web 浏览器上开箱即用,都是可接受与可信任的。

目前,实现的两个 ACME 端点是 Let’s Encrypt (LE) 产品和其暂存环境。我们的 ACME 客户端支持使用内置 Web 服务器校验 http-01 质询,并使用支持所有 DNS API 端点 acme.sh(shell 脚本) 的 DNS 插件验证 dns-01 质询。

您可以通过 Web 界面的 数据中心 -> ACME 或使用 pvenode 命令行工具注册和停用 ACME 帐户。

pvenode acme account register account-name mail@example.com

|

|

因为 rate-limits(速率限制),您应该使用 LE 的 staging 进行试验,或者如果您是初次使用 ACME。 |

ACME 插件的任务是提供自动验证,确保您以及您操作下的 Proxmox VE 集群是域的真正所有者。这是自动证书管理的基础构件。

ACME 协议规定了质询的不同类型,例如 http-01,其中 Web 服务器提供一个具有特定内容的文件以证明其控制一个域。有时这是不可能的,要么是因为技术限制,要么是因为无法从公共互联网访问记录的地址。在这种情况下可以使用 dns-01 质询。这个质询是通过在域的区域内创建特定的 DNS 记录来完成的。

ACME 插件配置存放在 /etc/pve/priv/acme/plugins.cfg 。一个插件可用于集群中的所有节点。

始终有一个隐式配置的 独立 插件,内置 Web 服务器通过 80 端口验证 http-01 验证。

|

|

独立 这个名称意味着它可以自己提供验证,而无需任何第三方服务。因此,这个插件也适用于集群节点。 |

使用 Let’s Encrypts ACME 进行证书管理需要满足有一些先决条件。

您必须接受 Let's Encrypt 的 ToS 才能注册帐户。

从 Internet 必须可以访问节点的 80 端口 。

不得 有其他侦听器在侦听 80 端口。

请求的(子)域需要解析为节点的公共 IP 。

在无法或不希望使用外部访问的方式进行 http-01 方式验证的系统上,可以使用 dns-01 验证方式。该验证方法需要一个允许通过 API 配置 TXT 记录的 DNS 服务器。

Proxmox VE 重新使用为 acme.sh

[acme.sh https://github.com/acmesh-official/acme.sh]

项目开发的 DNS 插件,请参阅其文档以了解有关特定 API 配置的详细信息。

使用 DNS API 配置新插件的最简单方法是使用 Web 界面。(数据中心 -> ACME)。

|

|

查看 acme.sh 如何使用 DNS API 的 wiki ,了解有关为您的供应商获取 API 凭据的更多详细信息。 |

由于有许多 DNS 提供商和 API 端点,Proxmox VE 会自动为某些提供商生成凭据表单。对于其他的,您将看到一个更大的文本区域,只需将所有凭证 KEY=VALUE 成对复制到其中。

一个特殊的 别名(alias) 模式可用于处理不同域/DNS 服务器上的验证,以防您的主要/实际的 DNS 不支持通过 API 进行配置。手动设置 _acme-challenge.domain1.example 指向 _acme-challenge.domain2.example 的一个永久的CNAME 记录,并将 Proxmox VE 节点配置文件中的 alias(别名)属性设置为 domain2.example,允许 domain2.example 的 DNS 服务器验证 domain1.example 的所有质询。

如果您的节点可通过具有不同要求或 DNS 配置功能的多个域访问,则可以组合使用 http-01 和 dns-01 验证。通过为每个域指定不同的插件实例,也可以混合来自多个提供者或实例的 DNS API 。

|

|

通过多个域访问同一服务会增加复杂性,应尽可能避免。 |

如果一个节点已经成功配置了 ACME 提供的证书(无论通过 pvenode 还是通过 GUI),证书将通过 pve-daily-update.service 自动续订。目前,如果证书已经过期或将在接下来的 30 天内过期,则会尝试续订。

root@proxmox:~# pvenode acme account register default mail@example.invalid Directory endpoints: 0) Let's Encrypt V2 (https://acme-v02.api.letsencrypt.org/directory) 1) Let's Encrypt V2 Staging (https://acme-staging-v02.api.letsencrypt.org/directory) 2) Custom Enter selection: 1 Terms of Service: https://letsencrypt.org/documents/LE-SA-v1.2-November-15-2017.pdf Do you agree to the above terms? [y|N]y ... Task OK root@proxmox:~# pvenode config set --acme domains=example.invalid root@proxmox:~# pvenode acme cert order Loading ACME account details Placing ACME order ... Status is 'valid'! All domains validated! ... Downloading certificate Setting pveproxy certificate and key Restarting pveproxy Task OK

|

|

无论使用什么插件,注册账号的步骤都是一样的,这里不再赘述。 |

|

|

根据 OVH API 文档,需要从 OVH 获取 OVH_AK 和 OVH_AS 。 |

首先,您需要获取所有信息,以便您和 Proxmox VE 可以访问 API 。

root@proxmox:~# cat /path/to/api-token

OVH_AK=XXXXXXXXXXXXXXXX

OVH_AS=YYYYYYYYYYYYYYYYYYYYYYYYYYYYYYYY

root@proxmox:~# source /path/to/api-token

root@proxmox:~# curl -XPOST -H"X-Ovh-Application: $OVH_AK" -H "Content-type: application/json" \

https://eu.api.ovh.com/1.0/auth/credential -d '{

"accessRules": [

{"method": "GET","path": "/auth/time"},

{"method": "GET","path": "/domain"},

{"method": "GET","path": "/domain/zone/*"},

{"method": "GET","path": "/domain/zone/*/record"},

{"method": "POST","path": "/domain/zone/*/record"},

{"method": "POST","path": "/domain/zone/*/refresh"},

{"method": "PUT","path": "/domain/zone/*/record/"},

{"method": "DELETE","path": "/domain/zone/*/record/*"}

]

}'

{"consumerKey":"ZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZ","state":"pendingValidation","validationUrl":"https://eu.api.ovh.com/auth/?credentialToken=AAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA"}

(open validation URL and follow instructions to link Application Key with account/Consumer Key)

root@proxmox:~# echo "OVH_CK=ZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZ" >> /path/to/api-token

现在,您可以设置 ACME 插件:

root@proxmox:~# pvenode acme plugin add dns example_plugin --api ovh --data /path/to/api_token root@proxmox:~# pvenode acme plugin config example_plugin ┌────────┬──────────────────────────────────────────┐ │ key │ value │ ╞════════╪══════════════════════════════════════════╡ │ api │ ovh │ ├────────┼──────────────────────────────────────────┤ │ data │ OVH_AK=XXXXXXXXXXXXXXXX │ │ │ OVH_AS=YYYYYYYYYYYYYYYYYYYYYYYYYYYYYYYY │ │ │ OVH_CK=ZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZ │ ├────────┼──────────────────────────────────────────┤ │ digest │ 867fcf556363ca1bea866863093fcab83edf47a1 │ ├────────┼──────────────────────────────────────────┤ │ plugin │ example_plugin │ ├────────┼──────────────────────────────────────────┤ │ type │ dns │ └────────┴──────────────────────────────────────────┘

最后,您可以配置要获取证书的域,并为其下证书订单:

root@proxmox:~# pvenode config set -acmedomain0 example.proxmox.com,plugin=example_plugin root@proxmox:~# pvenode acme cert order Loading ACME account details Placing ACME order Order URL: https://acme-staging-v02.api.letsencrypt.org/acme/order/11111111/22222222 Getting authorization details from 'https://acme-staging-v02.api.letsencrypt.org/acme/authz-v3/33333333' The validation for example.proxmox.com is pending! [Wed Apr 22 09:25:30 CEST 2020] Using OVH endpoint: ovh-eu [Wed Apr 22 09:25:30 CEST 2020] Checking authentication [Wed Apr 22 09:25:30 CEST 2020] Consumer key is ok. [Wed Apr 22 09:25:31 CEST 2020] Adding record [Wed Apr 22 09:25:32 CEST 2020] Added, sleep 10 seconds. Add TXT record: _acme-challenge.example.proxmox.com Triggering validation Sleeping for 5 seconds Status is 'valid'! [Wed Apr 22 09:25:48 CEST 2020] Using OVH endpoint: ovh-eu [Wed Apr 22 09:25:48 CEST 2020] Checking authentication [Wed Apr 22 09:25:48 CEST 2020] Consumer key is ok. Remove TXT record: _acme-challenge.example.proxmox.com All domains validated! Creating CSR Checking order status Order is ready, finalizing order valid! Downloading certificate Setting pveproxy certificate and key Restarting pveproxy Task OK

不支持更改帐户的 ACME 目录,但由于 Proxmox VE 支持多个帐户,您可以使用生产(可信)ACME 目录作为端点创建一个新帐户。您还可以停用暂存帐户并重新创建它。

root@proxmox:~# pvenode acme account deactivate default Renaming account file from '/etc/pve/priv/acme/default' to '/etc/pve/priv/acme/_deactivated_default_4' Task OK root@proxmox:~# pvenode acme account register default example@proxmox.com Directory endpoints: 0) Let's Encrypt V2 (https://acme-v02.api.letsencrypt.org/directory) 1) Let's Encrypt V2 Staging (https://acme-staging-v02.api.letsencrypt.org/directory) 2) Custom Enter selection: 0 Terms of Service: https://letsencrypt.org/documents/LE-SA-v1.2-November-15-2017.pdf Do you agree to the above terms? [y|N]y ... Task OK

根据安装程序中选择的磁盘设置,Proxmox VE 当前使用两个引导加载程序中的其中一个。

一个是以 ZFS 作为 root 文件系统,已安装使用systemd-boot 的 EFI 系统,另一个是所有其他部署使用标准的 grub bootloader(引导加载程序)(这通常也适用于安装在 Debian 之上的系统)。

Proxmox VE 安装程序在所有选择安装的磁盘上创建 3 个分区。

创建的分区是:

一个 1MB 的 BIOS 引导分区(gdisk 类型 EF02)

一个 512MB 的 EFI 系统分区(ESP分区,gdisk 类型 EF00)

第三个,使用设置的 hdsize 参数的分区,或者将剩余空间使用所选存储类型的分区

在使用 ZFS 作为 root 文件系统的系统上,通过存储在 512MB 的 EFI 系统分区上的内核与 initrd 映像进行引导。对于传统的 BIOS 系统,使用 grub ,为 EFI 系统使用 systemd-boot。两个都已安装并配置为指向 ESP 分区。

BIOS 模式下的 grub(--target i386-pc)安装在所有使用 grub

[这些都是在 ext4 或 xfs 上使用 root 安装,在非 EFI 系统上使用 root 安装在 ZFS 上]

引导的系统上的所有选定磁盘的 BIOS 引导分区上。

proxmox-boot-tool是一个实用程序,用于保持正确地配置和同步 EFI 系统分区的内容。它将某些内核版本复制到所有 ESP 分区,并将相应的 bootloader(引导加载程序) 配置为从 vfat 格式的 ESP 分区引导。在 ZFS 作为 root 文件系统的环境中,这意味着您可以使用在 root 池上的所有可选功能,而不是在 grub 里存在的子集与 grub 里的 ZFS 实现也存在的子集,或者不得不创建一个单独的小引导池

[使用 grub 在 root 上引导 ZFS https://github.com/zfsonlinux/zfs/wiki/Debian-Stretch-Root-on-ZFS]

。

通过安装程序,使得在冗余设置中,所有磁盘都带有一个 ESP 分区。这样可以确保即使第一个引导设备故障或 BIOS 只能从特定磁盘引导,系统也能引导。

ESP 常规操作期间不会保持挂载状态。这有助于在系统崩溃时,防止文件系统损坏波及到 vfat 格式的 ESP 分区,并且在主引导设备出现故障时无需手动调整 /etc/fstab 。

proxmox-boot-tool 处理以下任务:

格式化并设置新的分区

将新的内核映像和 initrd 映像复制并配置到所有列出的 ESP

在内核升级和其他维护任务时同步配置

管理已同步的内核版本列表

您可以通过运行以下命令查看当前配置的 ESP 及其状态:

# proxmox-boot-tool status

要格式化和初始化一个分区为同步 ESP 分区,例如,在替换 rpool 中一个出现故障的 vdev 之后,或者在转换一个同步机制之前的现有系统时,可以使用 pve-kernel-helpers 中 proxmox-boot-tool 。

|

|

format(格式化)命令将格式化 <partition>(分区),确保传递给正确的设备或分区! |

例如,要格式化一个空的分区 /dev/sda2 作为 ESP 分区,运行下列命令:

# proxmox-boot-tool format /dev/sda2

要设置一个位于 /dev/sda2 上的现有的且未挂载的 ESP 分区,同时包含在 Proxmox VE 的内核更新同步机制中,使用以下命令:

# proxmox-boot-tool init /dev/sda2

之后在 /etc/kernel/proxmox-boot-uuids 中应该包含一个带有新添加分区的 UUID 的新行。init 命令还将自动触发所有已配置 ESP 分区的刷新。

要复制和配置所有可引导的内核,并使得 /etc/kernel/proxmox-boot-uuids 中列出的所有 ESP 分区保持同步,您只需要运行:

# proxmox-boot-tool refresh

(相当于以 root 权限,在使用 ext4 或 xfs 的系统上运行 update-grub)。

如果您更改了内核命令行,或者想要同步所有内核和 initrd,这是必要的操作。

|

|

update-initramfs 和 apt(必要时)都会自动触发刷新。 |

默认配置了以下内核版本:

当前正在运行的内核

软件包更新时新安装的版本

最新安装的两个内核

倒数第二个内核系列的最新版本(例如 5.0、5.3),如果适用

任何手动选择的内核

如果您希望将某个内核和 initrd 映像添加到可引导内核列表中,请使用 proxmox-boot-tool kernel add 命令。

例如,运行以下命令将 ABI 版本 5.0.15-1-pve 的内核添加到内核列表中,以保持安装并同步到所有 ESP 分区:

# proxmox-boot-tool kernel add 5.0.15-1-pve

proxmox-boot-tool kernel list 将列出当前选择用于引导的所有内核版本:

# proxmox-boot-tool kernel list Manually selected kernels: 5.0.15-1-pve Automatically selected kernels: 5.0.12-1-pve 4.15.18-18-pve

运行 proxmox-boot-tool kernel remove 从手动选择的内核列表中删除内核,例如:

# proxmox-boot-tool kernel remove 5.0.15-1-pve

|

|

从上面手动添加或删除内核后,需要运行 proxmox-boot-tool refresh 来更新所有 EFI 系统分区 (ESP 分区)。 |

您将看到 grub 的蓝色框,或简单黑白的 systemd-boot 。

# efibootmgr -v

如果它返回不支持 EFI 变量的消息,在 BIOS/Legacy 模式中使用 grub 。

如果输出包含类似于以下内容的行,则在 UEFI 模式下使用 grub 。

Boot0005* proxmox [...] File(\EFI\proxmox\grubx64.efi)

如果输出包含类似于以下内容的行,则使用 systemd-boot 。

Boot0006* Linux Boot Manager [...] File(\EFI\systemd\systemd-bootx64.efi)

通过运行:

# proxmox-boot-tool status

您可以查看是否配置了 proxmox-boot-tool,这很好地表明了系统是如何启动的。

grub多年来一直是引导 Linux 系统的事实上的标准,并且有很好的文档记录

[Grub 手册 https://www.gnu.org/software/grub/manual/grub/grub.html]

。

对 grub 配置的更改是通过默认文件 /etc/default/grub 或 /etc/default/grub.d 中的配置片段完成的。要在更改配置后重新生成配置文件,请运行:

[使用 proxmox-boot-tool 的系统将在 update-grub 调用 proxmox-boot-tool refresh。]

# update-grub

systemd-boot 是一个轻量级的 EFI 引导加载程序。它直接从安装它的 EFI 服务分区 (ESP 分区) 读取内核和 initrd 映像。直接从 ESP 分区加载内核的主要优点是不需要重新实现访问存储的驱动程序。在 Proxmox VE 中,proxmox-boot-tool 用于保持 ESP 分区上的配置同步。

systemd-boot 是通过 EFI 系统分区(ESP 分区)里的根(root)目录中的文件 loader/loader.conf 配置的。有关详细信息,请参阅 loader.conf(5) 手册页。

每个 bootloader(引导加载程序)的条目都放置在目录 loader/entries/ 下的自己的文件中。

一个 entry.conf 的范例如下所示(/ 指的是 ESP 分区的根(root)):

title Proxmox version 5.0.15-1-pve options root=ZFS=rpool/ROOT/pve-1 boot=zfs linux /EFI/proxmox/5.0.15-1-pve/vmlinuz-5.0.15-1-pve initrd /EFI/proxmox/5.0.15-1-pve/initrd.img-5.0.15-1-pve

根据使用的 bootloader(引导加载程序),您可以在以下位置修改内核命令行:

内核命令行需要放置在文件 /etc/default/grub 中的变量 GRUB_CMDLINE_LINUX_DEFAULT 中。运行 update-grub 会将其内容附加到文件 /boot/grub/grub.cfg 中的所有 linux 条目。

内核命令行需要作为一行放置在 /etc/kernel/cmdline 文件中。要应用更改,请运行 proxmox-boot-tool refresh,它将其设置为 loader/entries/proxmox-*.conf 中所有配置文件的 option 行。

Proxmox VE 很简单。无需安装单独的管理工具,一切都可以通过您的浏览器完成(首选最新版的 Firefox 或 Google Chrome)。内置了 HTML5 控制台用于访问来宾控制台,还可以使用 SPICE 作为替代方案。

因为我们使用 Proxmox 集群文件系统(pmxcfs),您可以连接到任何节点来管理整个集群。每个节点可以管理整个集群,不需要专用的管理员节点。

您可以在任何现代的浏览器中使用基于 Web 的管理界面。当 Proxmox VE 检测到您正在从移动设备连接时,您将被重定向到一个更简单的、基于触摸的用户界面。

可以通过 https://youripaddress:8006 访问 Web 界面(默认登录名为:root,密码为安装过程中指定的密码)。

Proxmox VE 集群的无缝集成和管理

用于资源动态更新的 AJAX 技术

通过 SSL 加密(https)安全访问所有虚拟机和容器

快速搜索驱动的界面,能够处理成百上千个虚拟机

安全的 HTML5 控制台或 SPICE

所有对象( VM 、存储、节点等)的基于角色的权限管理

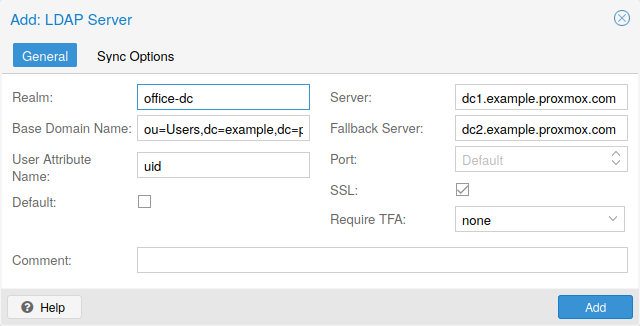

支持多个身份验证源(例如本地、MSADS、LDAP等)

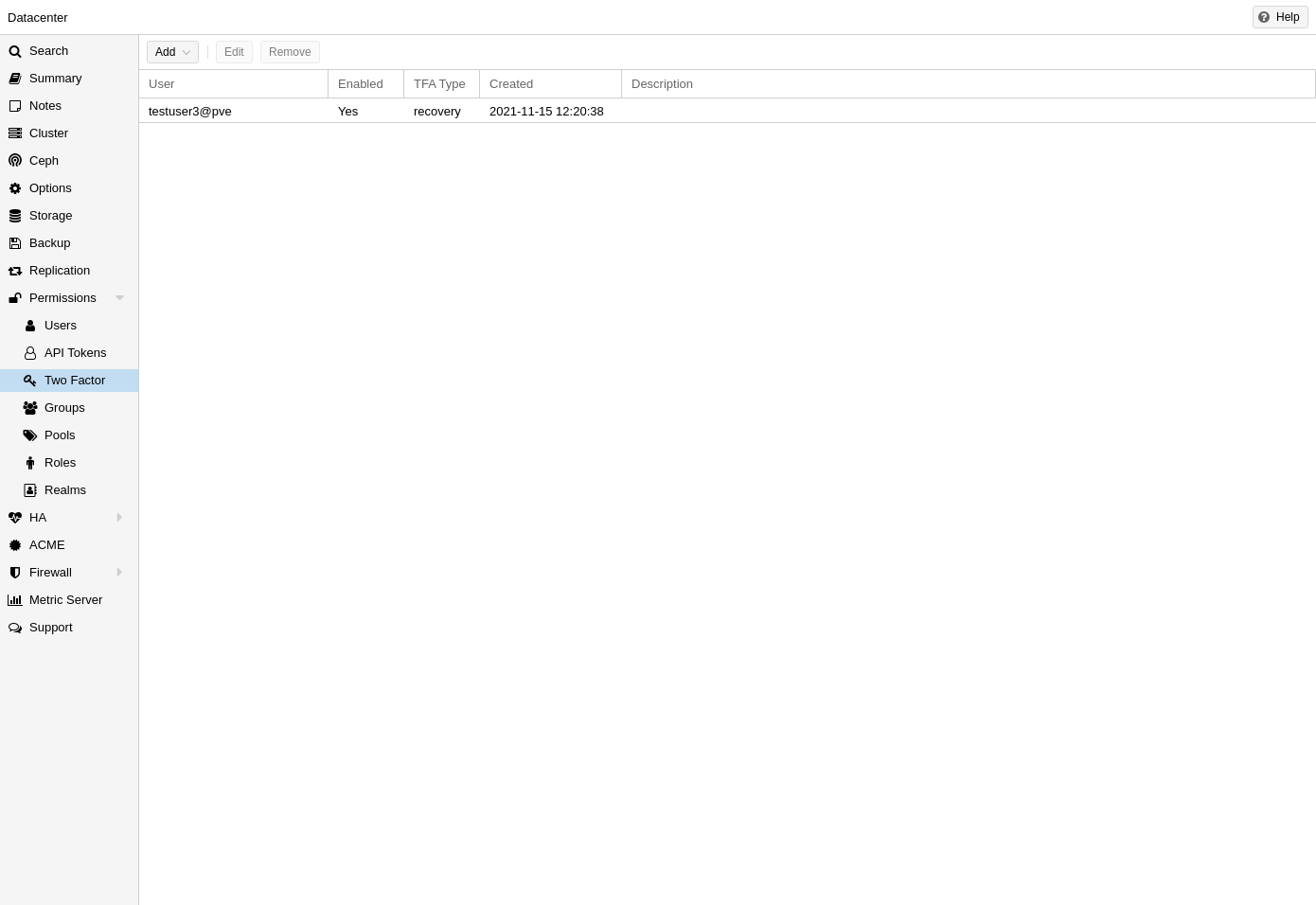

二次验证(OATH、Yubikey)

基于 ExtJS 6.x JavaScript 框架

|

|

您可以通过选择底部的复选框,在客户端保存用户名。这可以在您下次登录时节省一些输入。 |

| 页眉 |

最上面。显示状态信息并包括最重要操作的按钮。 |

| 资源树 |

在左侧。您可以在其中选择特定对象的导航树。 |

| 内容面板 |

中间区域。选定对象在此显示配置选项和状态。 |

| 日志面板 |

在底部。显示最近任务的日志条目。您可以双击这些日志条目以获取更多详细信息,或中止正在运行的任务。 |

|

|

您可以缩小和扩展资源树和日志面板的大小,或者完全隐藏日志面板。当您在小型显示器上工作并需要更多空间来查看其他内容时,这会很有帮助。 |

在左上角,您首先看到的是 Proxmox logo 标志。接下来是 Proxmox VE 当前运行的版本。在左侧的搜索栏中,您可以搜索特定的对象( VM 、容器、节点等)。这有时比在资源树中选择一个对象要快。

在搜索栏的右侧,我们会看到身份标识(登录名)。齿轮符号按钮用于打开 我的设置 对话框。在那里,您可以自定义一些客户端用户界面设置(重置已保存的登录名、重置已保存的布局)

页眉的最右侧部分包含四个按钮:

| 文档 |

打开一个新的浏览器窗口,显示参考文档。 |

| 创建虚拟机 |

打开虚拟机创建向导。 |

| 创建 CT |

打开容器创建向导。 |

| 注销 |

注销,并再次显示登录对话框。 |

在仪表板设置下面,您可以找到已保存的用户名和一个清除它的 重置 按钮,以及一个将 GUI 的所有布局重置为默认值的 重置 按钮。

在右侧是 xterm.js 设置 。这些包含以下选项:

| 字体系列 |

在 xterm.js 中使用的字体(例如 Arial)。 |

| 字体大小 |

要使用的首选字体大小。 |

| 字母间距 |

增加或减少文本中字母之间的间距。 |

| 行高 |

指定行的绝对高度。 |

这是主导航树。在树的顶部,您可以选择一些预定义的视图,这些视图会更改下面树的结构。默认视图是 服务器视图,它显示以下对象类型:

| 数据中心 |

包括集群范围内的设置(与所有节点相关) |

| 节点 |

代表集群内的主机,来宾在其中运行。 |

| 来宾 |

VM ,CT 和模板 |

| 存储 |

数据存储。 |

| 资源池 |

可以使用资源池将来宾分组以简化管理。 |

以下视图类型可用:

| 服务器视图 |

显示按节点分组的各种对象。 |

| 文件夹视图 |

显示按对象类型分组的各种对象。 |

| 存储视图 |

仅显示按节点分组的存储对象。 |

| 资源池视图 |

显示按资源池分组的 VM 和容器。 |

日志面板的主要目的是向您展示集群中当前正发生的事情。诸如创建新的 VM 之类的操作在后台执行,我们将这种后台作业称为 任务 。

此类任务的任何输出都保存在单独的日志文件中。您只需要双击一个任务日志条目即可查看该日志,也可以在那里中止正在运行的任务。

请注意,我们在此处显示了所有集群节点的最新任务。因此,您可以实时查看其他人何时在另一个集群节点上工作。

|

|

我们从日志面板中删除旧的和已完成的任务,以保持该列表简短。但是,您仍然可以在节点面板中的 任务历史 里找到这些任务的记录。 |

有些短期运行的操作只是将日志发送到所有集群成员。您可以在 集群日志 面板中看到这些消息。

当从资源树中选择一个项目时,相应的对象会在内容面板中显示配置和状态信息。以下章节简要概述了这些功能。请参阅参考文档中的相应章节以获取更多详细的信息。

搜索:对节点、 VM 、容器、存储设备和资源池执行集群范围的搜索。

摘要:简要概述集群的健康状况和资源使用情况。

集群:提供创建或加入集群所需的功能和信息。

选项:查看和管理集群范围的默认设置。

存储:提供用于管理集群存储的界面。

备份:计划备份作业。这在集群范围内运行,因此在调度时,VM 或容器在集群上的位置无关紧要。

复制:查看和管理复制作业

权限:管理用户、群组和 API 令牌权限,以及 LDAP、MS-AD 和二次验证。

HA:管理 Proxmox VE 高可用性。

ACME:为服务器节点设置 ACME(Let’s Encrypt)证书。

防火墙:为 Proxmox 防火墙集群范围配置和制作模板。

度量服务器:为 Proxmox VE 定义外部度量服务器。

支持:显示有关您的支持订阅的信息。

顶部页眉有一些有用的按钮,例如 重启、关机、Shell、批量操作 和 帮助。Shell 有 noVNC、SPICE 和 xterm.js 选项。批量操作 有 批量启动、批量停止 和 批量迁移 选项。

搜索:搜索节点中的 VM 、容器、存储设备和资源池。

摘要:显示节点资源使用情况的简要概述。

备注:使用 Markdown 语法 书写自定义的备注。

Shell:访问节点的 shell 界面。

系统:配置网络、DNS和时区设置,以及访问 syslog(系统日志)。

更新:升级系统并查看可用的新软件包。

防火墙:管理特定节点的 Proxmox 防火墙。

磁盘:获得附加磁盘的概览,并管理的它们使用方式。

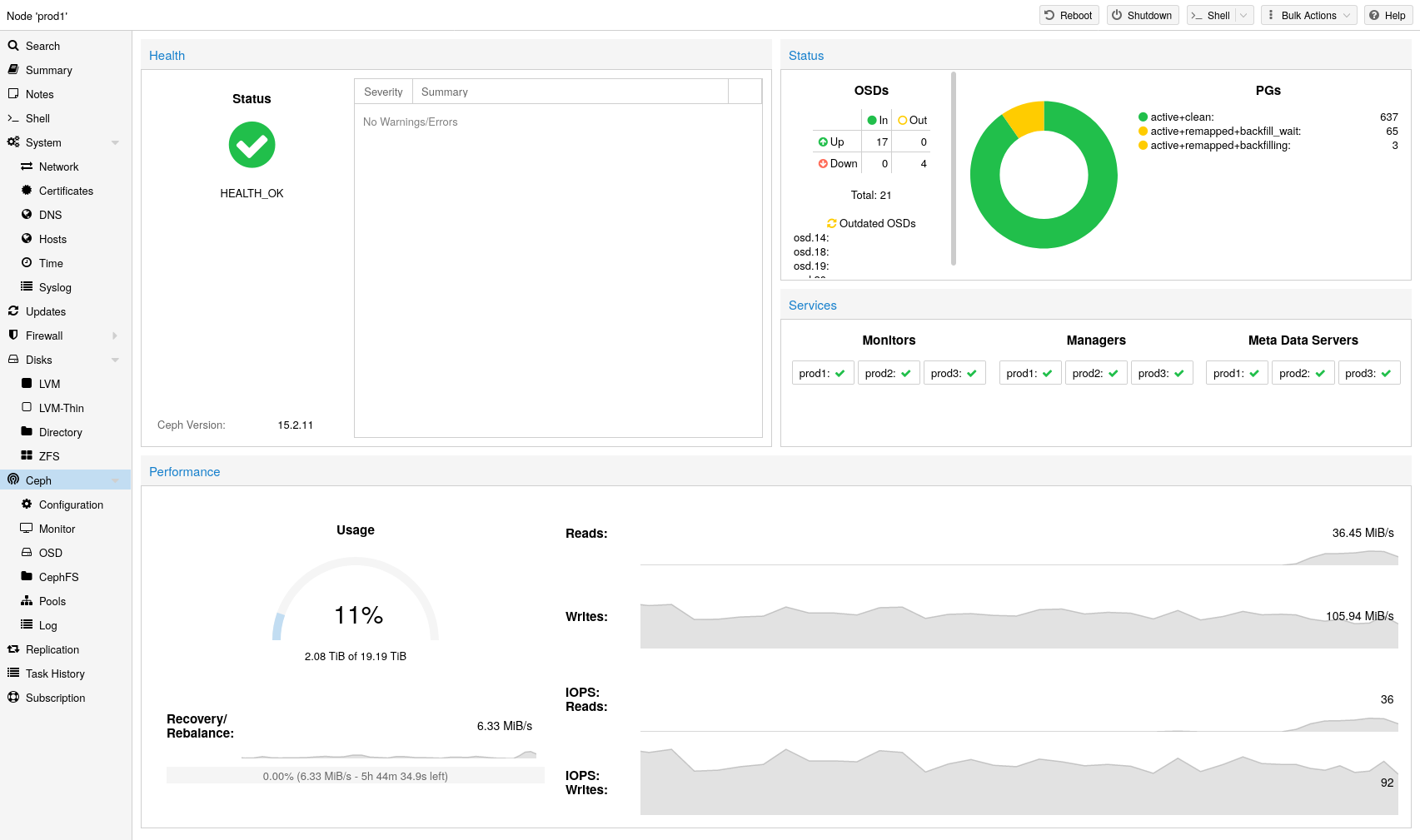

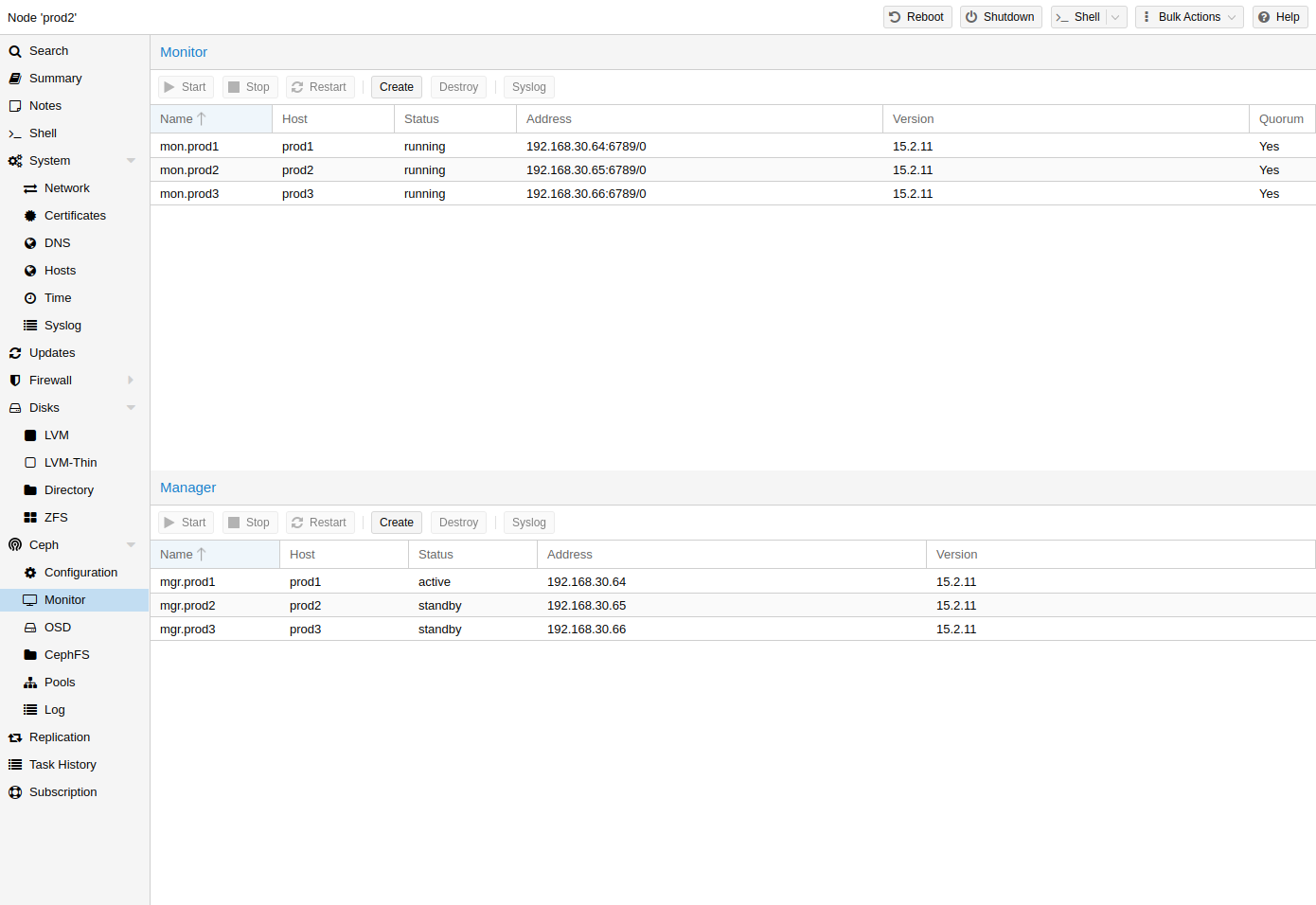

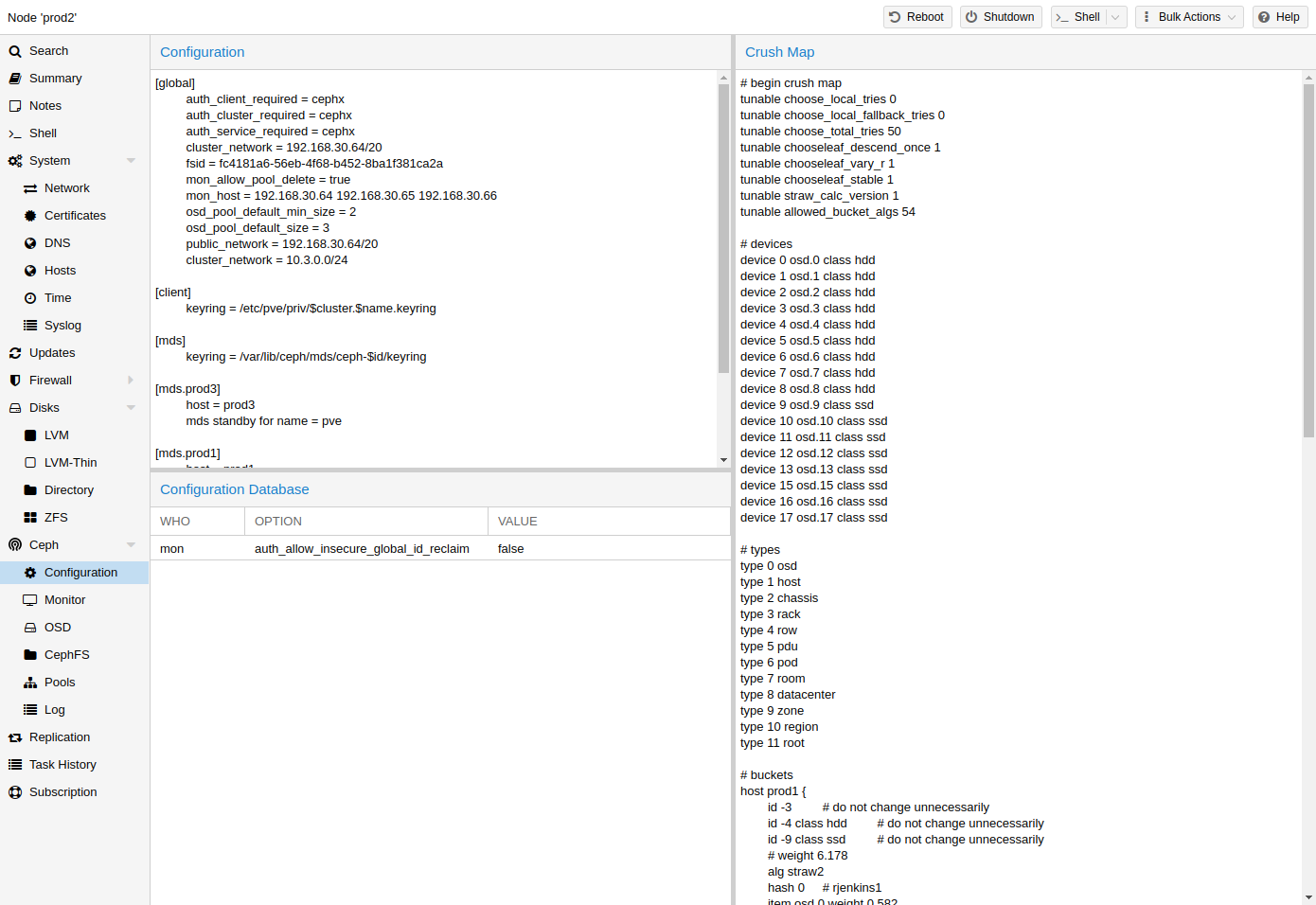

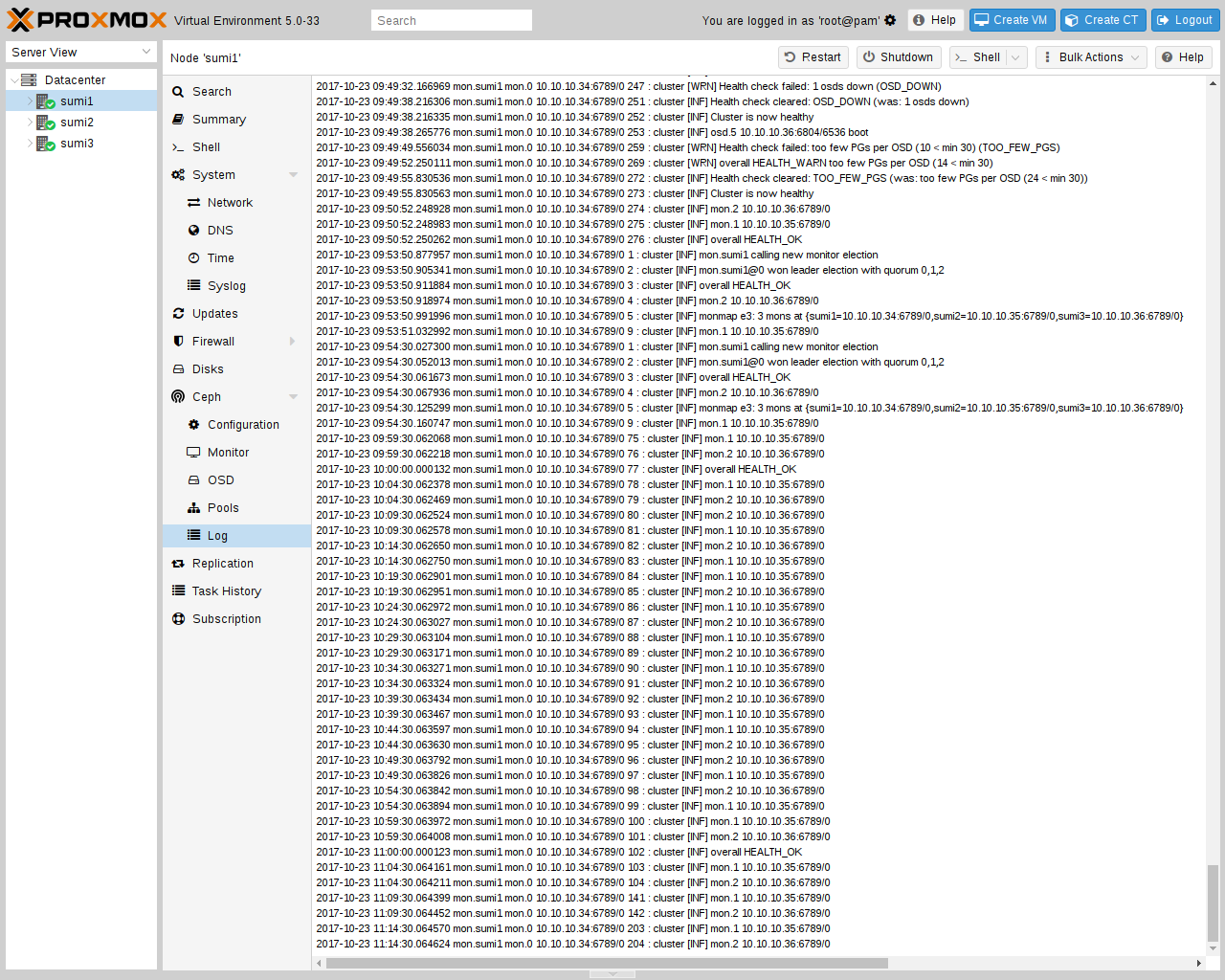

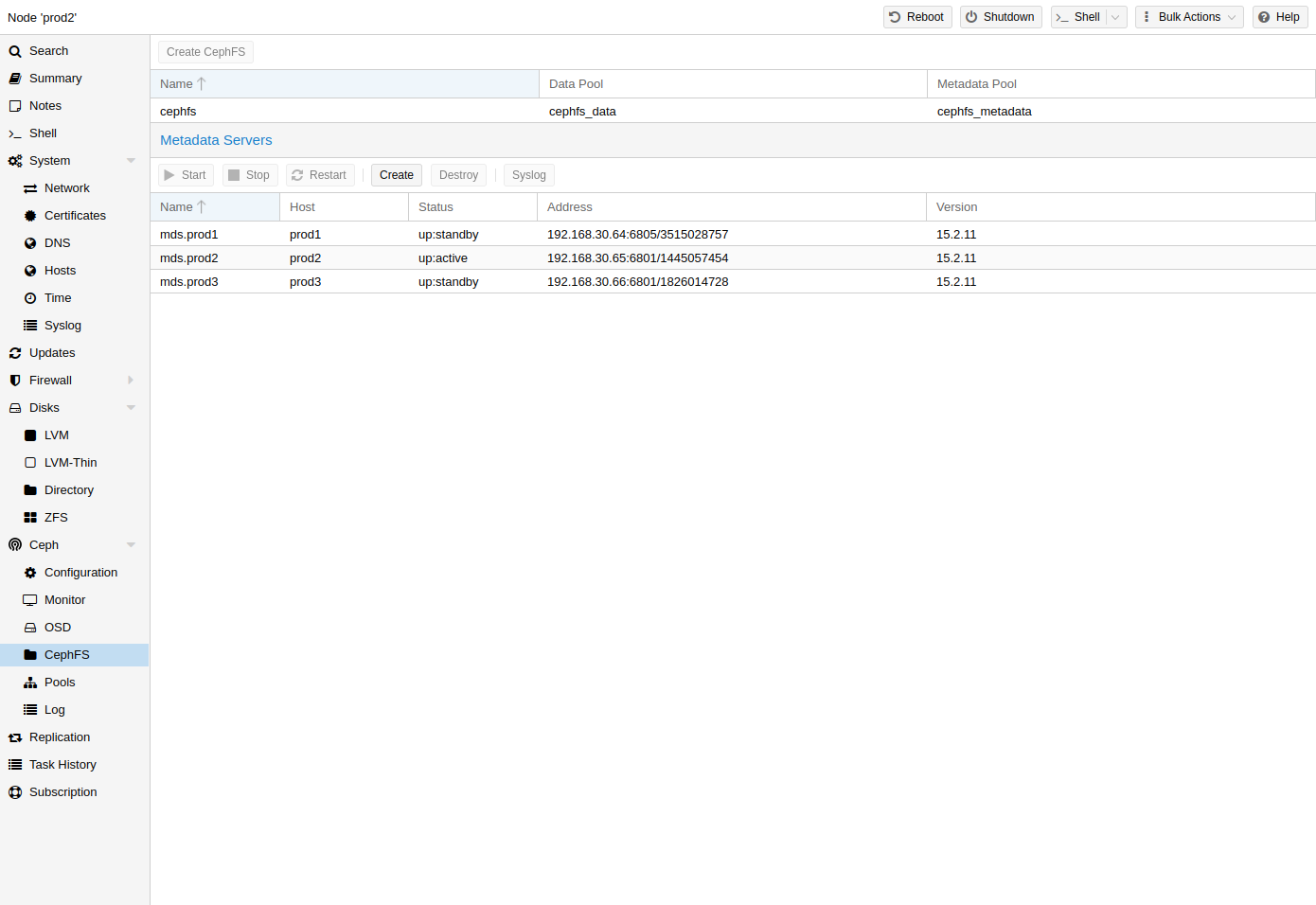

Ceph:仅在您的主机安装了 Ceph 服务器时使用。在这种情况下,您可以管理 Ceph 集群并在此处查看它的状态。

复制:查看和管理复制作业。

任务历史: 查看过去的任务列表。

订阅:上传订阅密钥,并生成用于支持案例的系统报告。

要访问来宾的各种管理界面,请在左侧菜单中选择一个 VM 或容器。

页眉包含诸如电源管理、迁移、控制台访问以及类型,克隆、HA 以及帮助等项目的命令。其中一些按钮包含下拉菜单,例如,关机 还包含其他电源选项,控制台 包括不同的控制台类型:SPICE、noVNC 和 xterm.js。

右侧的面板包含一个界面,用于显示从左侧菜单中选择的任何项目。

可用的界面如下所示。

摘要: 提供 VM 活动的简要概述,以及使用 Markdown 语法 注释的 备注 区域。

控制台:访问 VM /容器的交互式控制台。

硬件(虚拟机):定义 KVM VM 可用的硬件。

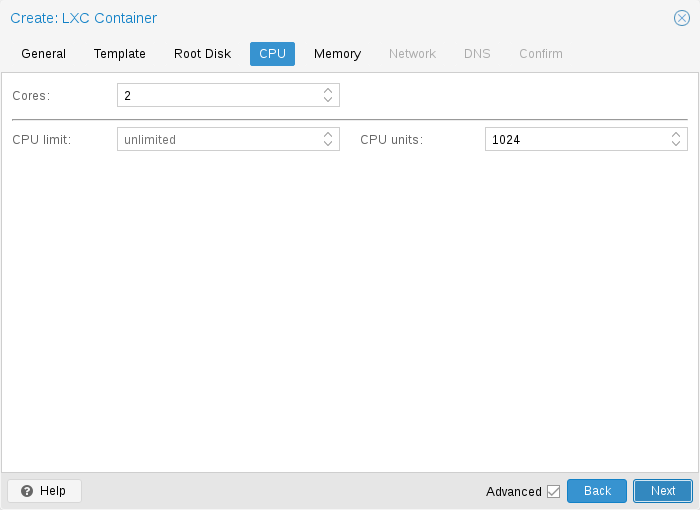

资源(容器):定义 LXC 容器可用的系统资源。

网络(容器):配置容器的网络设置。

DNS(容器):配置容器的 DNS 设置。

选项:管理来宾选项。

任务历史:查看与所选来宾相关的所有先前任务。

监视器(虚拟机):KVM 进程的交互式通信接口。

备份:创建与恢复系统备份。

复制:查看和管理所选来宾的复制作业。

快照:创建与恢复 VM 的快照。

防火墙:在 VM 级别配置防火墙。

权限:管理所选来宾的权限。

在这个视图中,我们有一个两个分区的拆分视图。在左侧,我们有存储选项,在右侧,将显示所选选项的内容。

摘要:显示关于存储的重要信息,例如存储的类型、用量以及所存储的内容。

内容:存储中储存的每种内容类型的菜单项,例如备份、ISO 光盘映像、CT 模板。

权限:管理存储的权限。

Proxmox VE 集群管理器 pvecm 是一个用于创建一组物理服务器的工具。这样的组称为 集群。我们使用 Corosync Cluster Engine 实现可靠的组通信。集群中的节点数量没有明确的限制。实际上,实际可用的节点数可能会受到主机和网络性能的限制。目前(2021 年),有报告称在生产环境中有超过50个节点的集群(使用高端企业硬件)。

pvecm 可用于创建新的集群,将节点加入到集群,离开集群,获取状态信息以及执行各种其他集群相关的任务。使用 Proxmox 集群文件系统(Proxmox Cluster File System (简称“pmxcfs”)),将集群配置透明地分发到所有集群节点。

将节点组合到集群中具有以下优点:

基于 Web 的集中管理

多主集群:每个节点可以做所有的管理任务

使用数据库驱动的文件系统 pmxcfs 来存储配置文件,使用 corosync 在所有节点上实时复制

在物理主机之间轻松迁移虚拟机和容器

快速部署

集群范围的服务,比如防火墙和 HA(高可用性)

所有节点必须能够通过 UDP 端口 5404 和 5405 相互连接,以便 corosync 可以正常工作。

日期和时间必须同步。

需要在节点之间的 TCP 端口 22 上建立 SSH 隧道。

如果您对高可用性感兴趣,则需要至少三个节点才能获得可靠的仲裁(quorum)。所有节点都应该具有相同的版本。

我们建议为集群流量使用专用 NIC,尤其是在您使用共享存储时。

添加节点需要集群节点的 root 密码。

|

|

Proxmox VE 3.x 及更早版本无法与 Proxmox VE 4.X 版本的集群节点混合使用。 |

|

|

虽然可以混合 Proxmox VE 4.4 和 Proxmox VE 5.0 节点,但不支持将其作为生产的配置,且只能在将整个集群从一个主要版本升级到另一个主要版本期间临时进行。 |

|

|

无法运行具有早期版本的 Proxmox VE 6.x 集群。Proxmox VE 6.x 和更早版本之间的集群协议(corosync)发生了根本性的变化。Proxmox VE 5.4 的 corosync 3 软件包仅计划用于升级到 Proxmox VE 6.0 的过程。 |

首先,在所有节点上安装 Proxmox VE 。确保每个节点都安装了最终的主机名和 IP 配置。创建集群后无法更改主机名和 IP 。

虽然在 /etc/hosts 中引用所有节点名称及其 IP(或通过其他方式解析它们的名称)是很常见的,但这对于集群的工作来说不是必需的。但是,它可能很有用,因为您可以使用更容易记住的节点名称(另请参阅 链接地址类型),通过 SSH 从一个节点连接到另一个节点。请注意,我们始终建议在集群配置中根据节点的IP地址引用节点。

您可以在控制台(通过登录 ssh)上创建集群,也可以通过 API 使用 Proxmox VE Web 界面(数据中心 → 集群)。

|

|

为您的集群使用唯一的名称。此名称以后无法更改。集群名称遵循与节点名称相同的规则。 |

从 Proxmox VE 6.2 开始,最多可以向一个集群添加 8 个后备(fallback)链接。要添加冗余链接,请单击 添加 按钮,然后从相应字段中选择链接编号和 IP 地址。在 Proxmox VE 6.2 之前,要添加第二个链接作为后备,您可以选中 高级 复选框并选择其他网络接口(Link 1,另请参见 Corosync 冗余)。

|

|

确保为集群通信选择的网络不用于任何高流量的用途,例如网络存储或实时迁移。虽然集群网络本身产生少量数据,但它对延迟非常敏感。查看完整的集群网络要求。集群网络需求。 |

通过 ssh 登录到第一个 Proxmox VE 节点并运行以下命令:

hp1# pvecm create CLUSTERNAME

要检查新集群的状态,请使用:

hp1# pvecm status

可以在同一个物理或逻辑网络中创建多个集群。在这种情况下,每个集群必须有一个唯一的名字,以避免在集群通信堆栈中可能发生的冲突。此外,通过使集群区别明显,有助于避免人为混淆。

虽然 corosync 集群的带宽需求相对较低,但是包延迟和包转发率(PPS)是限制因素。在同一网络中的不同集群可以相互竞争这些资源,因此,对于更大的集群使用单独的物理基础设施仍然是有意义的。

|

|

即将添加到集群的节点不能容纳任何来宾。加入集群时,在 /etc/pve 中的所有现有配置都将被覆盖,否则来宾的 ID 可能会发生冲突。作为一种变通方法,您可以在将节点添加到集群后,创建来宾的备份(vzdump)并以不同的 ID 恢复它。 |

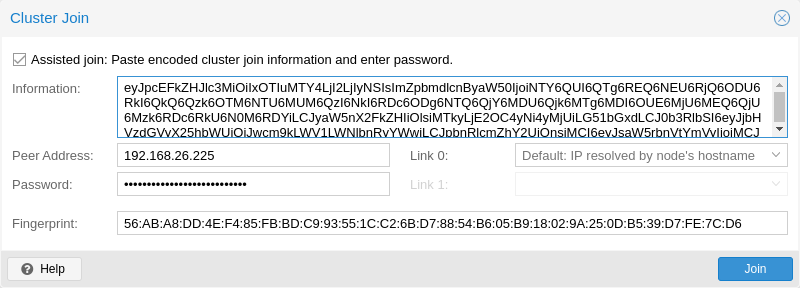

接下来,登录到要添加的节点上的 Web 界面。在 数据中心 → 集群 下面,单击 加入集群 。使用您之前复制的 加入信息 文本填写到 信息 字段。加入集群的大多数设置将自动填写。出于安全原因,必须手动输入集群的密码。

|

|

要手动输入所有必需的数据,您可以禁用 辅助加入 复选框。 |

单击 加入 按钮后,集群加入过程将立即开始。节点加入集群以后,它当前的节点证书将由集群证书颁发机构(CA)签署的证书替换。这意味着当前会话将在几秒钟后停止工作。然后您可能需要强制重载 Web 界面并使用集群凭据再次登陆。

现在,您的节点应该在 数据中心 → 集群 下可见。

通过 ssh 登录到要加入到现有集群的节点。

# pvecm add IP-ADDRESS-CLUSTER

对于 IP-ADDRESS-CLUSTER ,使用现有集群节点的 IP 或主机名。建议使用 IP 地址(请参阅 链路地址类型)。

要检查集群的状态,请使用:

# pvecm status

# pvecm status

Cluster information

~~~~~~~~~~~~~~~~~~~

Name: prod-central

Config Version: 3

Transport: knet

Secure auth: on

Quorum information

~~~~~~~~~~~~~~~~~~

Date: Tue Sep 14 11:06:47 2021

Quorum provider: corosync_votequorum

Nodes: 4

Node ID: 0x00000001

Ring ID: 1.1a8

Quorate: Yes

Votequorum information

~~~~~~~~~~~~~~~~~~~~~~

Expected votes: 4

Highest expected: 4

Total votes: 4

Quorum: 3

Flags: Quorate

Membership information

~~~~~~~~~~~~~~~~~~~~~~

Nodeid Votes Name

0x00000001 1 192.168.15.91

0x00000002 1 192.168.15.92 (local)

0x00000003 1 192.168.15.93

0x00000004 1 192.168.15.94

如果只想列出所有节点,请使用:

# pvecm nodes

# pvecm nodes

Membership information

~~~~~~~~~~~~~~~~~~~~~~

Nodeid Votes Name

1 1 hp1

2 1 hp2 (local)

3 1 hp3

4 1 hp4在集群网络分离的集群中添加节点时,需要使用 link0 参数设置该网络上的节点地址:

pvecm add IP-ADDRESS-CLUSTER -link0 LOCAL-IP-ADDRESS-LINK0

如果要使用 Kronosnet 传输层的内置 冗余,还要使用 link1 参数。

使用 GUI 界面,您可以从 加入集群 对话框中相应的 Link X 字段中选择正确的接口。

|

|

在继续之前仔细阅读该过程,因为它可能不是您想要或需要的。 |

从节点移动所有虚拟机。确保您已经生成了要保留的任何本地数据或备份的副本。此外,请确保要删除的节点已经删除掉任何计划的复制作业。

|

|

在删除节点之前未能将复制作业删除,将导致复制作业变得不可删除。特别要注意的是,如果迁移复制的 VM ,复制会自动切换方向,因此通过从要删除的节点迁移复制的 VM ,复制作业将会自动设置到该节点。 |

在以下范例中,我们将从集群中删除节点 hp4 。

登录到一个 不同的 集群节点(非 hp4),并发出 pvecm nodes 命令来标识要删除的节点 ID:

hp1# pvecm nodes

Membership information

~~~~~~~~~~~~~~~~~~~~~~

Nodeid Votes Name

1 1 hp1 (local)

2 1 hp2

3 1 hp3

4 1 hp4此时,您必须关闭 hp4 并确保它不会以其当前的配置再次启动(在网络中)。

|

|

如上所述,在移除节点之前关闭电源至关重要,并确保它将不会以其当前的配置再次开启(在现在集群网络中)。如果按原样开启节点,集群最终可能会损坏,并且可能难以将其恢复到正常运行状态。 |

关闭节点 hp4 的电源后,我们可以安全地将其从集群中移除。

hp1# pvecm delnode hp4 Killing node 4

|

|

此时,您可能会接收到一条显示为 Could not kill node (error = CS_ERR_NOT_EXIST)(无法终止节点) 的错误消息。实际上这并不意味着节点删除失败,更准确的说是在尝试停止离线节点的 corosync 时发生失败。因此,可以安全地忽略它。 |

使用 pvecm nodes 或 pvecm status 再次检查节点列表。它应该看起来像:

hp1# pvecm status

...

Votequorum information

~~~~~~~~~~~~~~~~~~~~~~

Expected votes: 3

Highest expected: 3

Total votes: 3

Quorum: 2

Flags: Quorate

Membership information

~~~~~~~~~~~~~~~~~~~~~~

Nodeid Votes Name

0x00000001 1 192.168.15.90 (local)

0x00000002 1 192.168.15.91

0x00000003 1 192.168.15.92无论出于何种原因,如果您希望此服务器再次加入同一个集群,您必须:

在其上重新安装 Proxmox VE

然后加入它,如前一节所述。

|

|

移除节点以后,它的 SSH 指纹信息仍将驻留在其他节点的已知主机(known_hosts)中。如果在重新加入具有相同 IP 或主机名的节点后收到一个 SSH 错误,请在重新添加的节点上运行一次 pvecm updatecerts 以更新集群范围的指纹信息。 |

|

|

这 不是 推荐的方法,请谨慎操作。如果您不确定,请使用前面的方法。 |

您还可以将节点与集群分离,而无需从头开始重新安装。但是从集群中删除节点后,它仍然可以访问任何共享存储。这必须在开始从集群中删除节点之前解决此问题。Proxmox VE 集群不能与另一个集群共享完全相同的存储,因为存储锁定在集群边界上不起作用。此外,它还可能导致 VMID 冲突。

建议您新建一个存储,只有您要分离的节点才能访问。仅举几个例子,这可以是 NFS 上新导出的或者新的 Ceph 资源池。很重要的一点是多个集群不会访问完全相同的存储。设置此存储后,将所有数据和 VM 从节点移动到该存储。然后您可以将节点从集群中分离出来了。

|

|

确保所有共享资源完全分离!否则您会遇到冲突和问题。 |

首先,停止节点上的 corosync 和 pve-cluster 服务:

systemctl stop pve-cluster systemctl stop corosync

在本地模式下再次启动集群文件系统:

pmxcfs -l

删除 corosync 配置文件:

rm /etc/pve/corosync.conf rm -r /etc/corosync/*

现在,您可以把文件系统作为普通服务再次启动:

killall pmxcfs systemctl start pve-cluster

该节点现在与集群分离。您可以使用以下命令从集群的任何其余节点中删除它:

pvecm delnode oldnode

如果由于剩余节点中的仲裁(quorum)丢失而导致命令失败,您可以将预期投票数(votes)设置为 1 作为解决方法:

pvecm expected 1然后重复 pvecm delnode 命令。

现在切换回分离的节点并删除其上所有剩余的集群文件。这确保节点可以毫无问题地再次添加到另一个集群。

rm /var/lib/corosync/*由于来自其他节点的配置文件仍在集群文件系统中,您可能也需要清理它们。在绝对确保您拥有正确的节点名称后,您可以简单地从 /etc/pve/nodes/NODENAME(节点名称) 递归删除整个目录

|

|

节点的 SSH 密钥将保留在 authorized_key 文件中。这意味着节点仍然可以通过公钥认证相互连接。您可以从 /etc/pve/priv/authorized_keys 文件中删除相应的密钥来解决此问题。 |

Proxmox VE 使用基于仲裁(quorum)的技术在所有集群节点之间提供一致的状态。

仲裁(quorum)是分布式事务必须获得的最小投票数,以便允许在分布式系统中执行操作。

在网络分区的情况下,状态更改需要大多数节点在线。如果失去仲裁,集群将切换到只读模式。

|

|

默认情况下,Proxmox VE 为每个节点分配一票。 |

集群网络是集群的核心。通过它发送的所有消息都必须按照各自的顺序可靠地传递给所有节点。在 Proxmox VE 中,这部分由 corosync 完成,这是一个高性能、低开销、高可用性的开发工具箱的实现。它提供给我们一个去中心化配置的文件系统。(pmxcfs,即 Proxmox VE 集群文件系统)。

这需要一个延迟低于 2 毫秒(LAN 性能)的可靠网络才能正常工作。该网络不应被其他成员大量使用;理想情况下,corosync 运行在自己的网络上。不要将共享网络用于 corosync 和存储(除非作为 冗余 配置中潜在的低权后备)。

在设置集群之前,最好先检查网络是否适合该目的。为了确保集群网络上的节点可以相互连接,您可以使用 ping 工具测试它们之间的连通性。

如果已启用 Proxmox VE 防火墙,将会自动为 corosync 生成 ACCEPT 规则 - 无需手动操作。

|

|

Corosync 在 3.0 版本之前使用多播(在 Proxmox VE 6.0 中引入)。新的版本依赖 Kronosnet 进行集群通信,目前仅支持常规的 UDP 单播。 |

|

|

您仍然可以通过在 corosync.conf 中将传输设置为 udp 或 udpu 来启用多播或传统单播,但是请记住,这将禁用所有加密和冗余支持,因此不推荐这样做。 |

当创建未带任何参数的集群时,corosync 集群通常与 Web 界面和 VM 共享同一个网络。根据您的设置,甚至存储的流量也可能通过同一个网络发送。建议进行更改,毕竟 corosync 是一个注重时效性的实时应用程序。

首先,您必须设置一个新的网络接口。它应该是物理上的单独网络。确保您的网络满足 集群网络需求。

这可以通过用于创建新集群的命令 pvecm create 的 linkX 参数实现。

如果您已经为附加的 NIC 设置了静态地址 10.10.10.1/25 ,并希望通过该接口发送和接收所有集群通信,您将执行:

pvecm create test --link0 10.10.10.1

要检查一切是否正常,请执行:

systemctl status corosync

之后,按上述步骤 添加具有分离集群网络的节点 。

如果您已经创建了一个集群并希望将其通信切换到另一个网络,您可以这样做,而无需重建整个集群,但是,这一变化可能会导致集群中的仲裁(quorum) 出现短时间的丢失,因为节点必须重启 corosync 并在新的网络上一个接一个地出现。

首先检查如何 编辑 corosync.conf 文件 。然后打开它,您应该会看到以下类似的内容:

logging {

debug: off

to_syslog: yes

}

nodelist {

node {

name: due

nodeid: 2

quorum_votes: 1

ring0_addr: due

}

node {

name: tre

nodeid: 3

quorum_votes: 1

ring0_addr: tre

}

node {

name: uno

nodeid: 1

quorum_votes: 1

ring0_addr: uno

}

}

quorum {

provider: corosync_votequorum

}

totem {

cluster_name: testcluster

config_version: 3

ip_version: ipv4-6

secauth: on

version: 2

interface {

linknumber: 0

}

}|

|

ringX_addr 实际上指定了一个 corosync 的 链路地址 。“ring”这个名字是为了与旧版的 corosync 保持向后兼容而遗留的。 |

如果您未看到它们,那您要做的第一件事情是在节点条目中添加 name(名字)属性。这些 必须 与节点的名称匹配。

然后,使用新的地址替换所有节点的 ring0_addr 属性的所有地址。您可以在此处直接使用 IP 地址或主机名。如果您使用主机名,确保它们可以从所有节点被解析(另请参阅 链路地址类型)。

在这个范例中,我们想将集群通信切换到 10.10.10.1/25 网络,所以我们分别更改了每个节点的 ring0_addr 。

|

|

完全相同的过程也可用于更改其它 ringX_addr 值。但是,我们建议一次只更改一个链路地址,以便在出现问题时更容易恢复。 |

在我们增加 config_version 属性后,新的配置文件应该如下所示:

logging {

debug: off

to_syslog: yes

}

nodelist {

node {

name: due

nodeid: 2

quorum_votes: 1

ring0_addr: 10.10.10.2

}

node {

name: tre

nodeid: 3

quorum_votes: 1

ring0_addr: 10.10.10.3

}

node {

name: uno

nodeid: 1

quorum_votes: 1

ring0_addr: 10.10.10.1

}

}

quorum {

provider: corosync_votequorum

}

totem {

cluster_name: testcluster

config_version: 4

ip_version: ipv4-6

secauth: on

version: 2

interface {

linknumber: 0

}

}然后,在最后检查所有更改的信息是否正确后,我们将其保存并再次按照 编辑 corosync.conf 文件 章节的操作使其生效。

更改将立即生效,因此重新启动 corosync 并不是有绝对的必要。如果您还更改了其他设置,或者注意到 corosync 出现问题,您可以选择触发重新启动。

在单个节点上执行:

systemctl restart corosync

现在检查是否一切正常:

systemctl status corosync

如果 corosync 再次开始工作,也请在所有其他节点上重新启动它。然后它们将在新网络上作为成员逐个加入集群。

Corosync 链路地址(使用 ringX_addr 在 corosync.conf 文件中作为向后兼容的标志)可以通过两种方式指定:

IPv4/v6 地址 可以直接使用。推荐使用它们,因为它们是静态且通常不会随意更改。

主机名 将使用 getaddrinfo 进行解析,这意味着在默认情况下,如果可用,将首先使用 IPv6 地址(另请参阅 man gai.conf)。请记住这一点,尤其是在将现有集群升级到 IPv6 时。

|

|

应该谨慎使用主机名,因为它们解析的地址可以在不接触 corosync 或其运行的节点的情况下进行更改——在未考虑对 corosync 产生影响的情况下,地址的更改可能会导致状况。 |

如果首选使用主机名,推荐为 corosync 使用单独的、专用的静态主机名。此外,请确保集群中的每个节点都可以正确的解析所有主机名。

从 Proxmox VE 5.1 开始才支持,主机名将在加入时进行解析。只有解析的 IP 才会保存到配置中。

在早期版本中,加入集群的节点可能仍使用 corosync.conf 中未解析的主机名。如上所述,用 IP 或单独的主机名替换它们是个不错的主意。

在默认情况下,Corosync 通过其集成的 Kronosnet 层支持冗余网络(它不支持在传统的 udp/udpu 上传输)。它可以通过指定多个链接地址来启用,或者通过 pvecm 的 --linkX 参数,然后在 GUI 中作为 Link 1(在创建集群或添加新节点时),又或者通过在 corosync.conf 中指定多个 ringX_addr。

|

|

为了提供有用的故障转移,每个链接都应该在自己的物理网络连接上。 |

根据优先级设置使用链路。您可以在 corosync.conf 的相应接口部分中,通过设置 knet_link_priority 来配置此优先级,或者最好在使用 pvecm 创建集群时使用优先级参数:

# pvecm create CLUSTERNAME --link0 10.10.10.1,priority=15 --link1 10.20.20.1,priority=20

这将会优先使用 link1 ,因为它具有更高的优先级(priority=20)。

如果未手动配置优先级(或两条链路具有相同优先级),则按照链路编号的顺序使用,编号越小的优先级越高。

即使所有链路都在工作,只有具有最高优先级的链接才能看到 corosync 的数据流量。链接优先级不能混淆,这意味着具有不同优先级的链路将无法相互通信。

由于低优先级的链路无法看到数据流量,除非所有高优先级的都发生故障,一种有用的规划是将用于其他任务( VM 、存储等)的网络指定为低优先级链路。如果发生最坏的情况,更高的延迟或更拥挤的连接可能好过完全没有连接。

要向正在运行的配置添加新的链接,请首先查看如何 编辑 corosync.conf 文件。

然后,在 nodelist 部分中的每个节点添加一个新的 ringX_addr。确保您的 X 与添加到的每个节点都相同,并且对于每个节点都是唯一的。

最后,添加一个新的 interface 到 totem 部分,如下所示,使用上面选择的链接编号替换 X 。

假设您添加了一个编号为 1 的链接,新的配置文件可能如下所示:

logging {

debug: off

to_syslog: yes

}

nodelist {

node {

name: due

nodeid: 2

quorum_votes: 1

ring0_addr: 10.10.10.2

ring1_addr: 10.20.20.2

}

node {

name: tre

nodeid: 3

quorum_votes: 1

ring0_addr: 10.10.10.3

ring1_addr: 10.20.20.3

}

node {

name: uno

nodeid: 1

quorum_votes: 1

ring0_addr: 10.10.10.1

ring1_addr: 10.20.20.1

}

}

quorum {

provider: corosync_votequorum

}

totem {

cluster_name: testcluster

config_version: 4

ip_version: ipv4-6

secauth: on

version: 2

interface {

linknumber: 0

}

interface {

linknumber: 1

}

}只要您按照最后的步骤 编辑 corosync.conf 文件,就会启用新的链接,而无需重启。您可以使用以下方式检查 corosync 是否加载了新的链接:

journalctl -b -u corosync

有一个不错的测试新链接的办法,就是通过临时断开一个节点上的旧链接并确保其状态在断开连接时能保持在线:

pvecm status

如果您看到健康的集群状态,则意味着正在使用您的新链接。

Proxmox VE 利用 SSH 隧道实现各种功能。

代理控制台/控制台会话(节点和来宾)

当连接到节点 A 的同时为节点 B 使用控制台时,会连接到节点 A 上的终端代理,而终端代理又通过非交互式的 SSH 隧道连接并登录控制台到节点 B 上。

使用 安全 模式迁移 VM 与 CT 的内存和本地存储。

在迁移过程中,源节点和目标节点之间会建立一个或多个 SSH 隧道,以便交换迁移信息并传输内存和磁盘内容。

存储复制

|

|

自动执行 .bashrc 和类似文件的缺陷

如果您有自定义的 .bashrc 或类似的文件,这些文件配置为控制台登录时执行,ssh 将会在成功建立会话时自动运行一次。这可能会导致一些意外行为,因为这些命令可能会以 root 权限执行以上任何操作。这问题可能会造成负面效应! 为了避免这种复杂情况,建议在 /root/.bashrc 中添加检查以确保会话是交互式的,然后才能运行 .bashrc 命令。 您可以在 .bashrc 文件的开头添加此代码段: # Early exit if not running interactively to avoid side-effects!

case $- in

*i*) ;;

*) return;;

esac |

本节描述了一种在 Proxmox VE 集群中部署外部投票器的方法。配置之后,集群可以承受更多的节点故障,而不会违反集群通信的安全属性。

为此,需要两个服务参与:

在每个 Proxmox VE 节点上运行一个 QDevice 守护进程。

在独立服务器上运行的外部投票守护进程

因此,即使在小型的设置中(例如 2+1 个节点),也可以实现更高的可用性。

Corosync 仲裁设备(Quorum Device,简称 QDevice)是一个运行在每个集群节点上的守护进程。它根据外部运行的第三方仲裁员的决定,为集群的仲裁子系统提供一个配置的投票数。它的主要用途是允许集群可以承受比标准仲裁规则允许的更多的节点故障。由于外部设备可以看到所有节点,因此只要选择一组节点就可以安全地完成投票。只有在收到第三方投票后,所述节点群(再次)达到规定数量时,才会这样做。

目前,仅支持 QDevice Net 作为第三方仲裁者。这是一个守护进程,它为集群分区提供投票权,前提是它可以通过网络到达分区的成员。它在任何时候都只会给集群的一个分区投票。它旨在支持多个集群并且几乎无需配置和无状态的。新的集群是动态处理的,在运行 QDevice 的主机上不需要配置文件。

对于外部主机的唯一要求是它需要通过网络访问到集群,并拥有可用的 corosync-qnetd 软件包。我们为基于 Debian 的主机提供了一个软件包,其他 Linux 发行版也应该拥有通过它们各自的包管理器提供的软件包。

|

|

与 corosync 本身不同,QDevice 通过 TCP/IP 连接到集群。守护进程甚至可能在集群的 LAN 之外运行,并且可能具有超过 2 毫秒的延迟。 |

我们支持将 QDevice 用于节点数为偶数的集群,如果推荐将它用于 2 个节点的集群,它们应该会提供更高的可用性。目前我们不鼓励将 QDevice 用于节点数为奇数的集群,其原因是 QDevice 为每种类型的集群提供不相同的投票数。偶数集群会获得单一的附加票,这只会增加可用性,因为如果 QDevice 自身出现故障,您的处境等同于完全没有 Device 。

另一方面,对于奇数大小的集群,QDevice 提供 (N-1) 票数 — 其中 N 对应于集群的节点数量。这是种合理的替代行为;如果它只有一个附加票,集群可能会陷入分裂的局面。该算法允许除一个节点(当然还有 QDevice 自身)之外的所有节点发生故障。但是,这样做有两个缺点:

如果 QNet 守护进程自身发生故障,则其他节点可能不会发生故障或集群将立即失败仲裁。例如,在有 15 个节点的集群中,可能有 7 个节点在集群的规定数量不达标之前就已经发生故障。但是,如果在这里配置了 QDevice 并且它自身出现故障,则 15 个节点中可能没有一个节点会发生故障。在这种情况下,QDevice 几乎充当了单点故障。

事实上一开始,除了一个节点和 QDevice 之外的所有节点都可能出现故障,这听起来很有希望,但这可能会导致 HA 服务的大量恢复,它可能会导致剩余的单个节点过载。此外,如果只有 ((N-1)/2) 个或更少的节点保持在线状态,Ceph 服务器将停止提供服务。

如果您了解这些缺点和影响,您可以自行决定是否要在奇数的集群设置中使用此技术。